กูเกิลส่งเสริมการประมวลผล AI ขนาดเบาภายในตัวเครื่องสมาร์ทโฟน (on-device ML) มาได้สักพักใหญ่ๆ โดยตัวระบบปฏิบัติการ Android มีฟีเจอร์ชื่อ Neural Networks API (NNAPI) มาตั้งแต่ Android 8.1 เพื่อให้เฟรมเวิร์ค AI เรียกใช้งานชิปประมวลผลในเครื่อง (GPU หรือ NPU แล้วแต่ฮาร์ดแวร์มีให้ใช้)

ก่อนหน้านี้ เฟรมเวิร์ค AI ที่รองรับ Android NNAPI มีเพียงแค่ TensorFlow Lite ที่พัฒนาโดยกูเกิลเอง แต่ล่าสุด เฟรมเวิร์คยอดนิยมอีกตัวคือ PyTorch (ทีมพัฒนาหลักคือ Facebook) ประกาศรองรับ NNAPI อย่างเป็นทางการแล้ว

PyTorch Mobile บน NNAPI ยังอยู่ในขั้นเริ่มต้น แต่ก็รองรับฟีเจอร์พื้นฐานจำนวนหนึ่ง ทีมงาน PyTorch ระบุว่า on-device AI เหมาะสำหรับงานที่ต้องใช้งานแบบเรียลไทม์ตลอดเวลา และจำเป็นต้องมี latency ต่ำ เช่น งานด้านประมวลผลภาพที่มองเห็นได้ทันที (computer vision) หรือการตัดเสียงรบกวน (noise reduction) ซึ่งก่อนหน้านี้เป็นรูปแบบการคำนวณที่สิ้นเปลืองพลังงานมาก จึงท้าทายมากในการรันบนมือถือ

แต่เมื่อมี NNAPI ขึ้นมาให้เรียกใช้ฮาร์ดแวร์เฉพาะช่วยประมวผลได้ ทำให้ Facebook สนใจและหันมาซัพพอร์ตฟีเจอร์นี้ และมีตัวอย่างการวิดีโอคอลล์แอพ Messenger โดยใช้ AI ช่วยตัดฉากหลังออก แล้วใส่ภาพพื้นหลังแบบ 360 องศาเข้ามาแทนได้

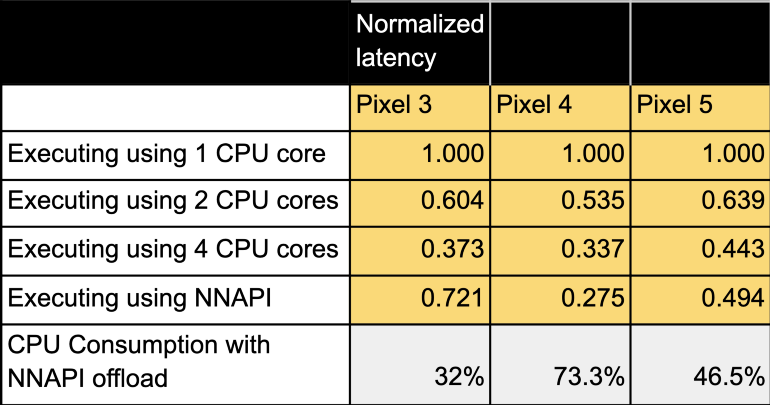

ตัวเลขที่ทีม PyTorch นำมาโชว์คือการใช้ NNAPI สามารถช่วยลดการใช้ซีพียูลงได้ 32% บน Pixel 3, 73.3% บน Pixel 4 และ 46.5% บน Pixel 5

ที่มา - PyTorch, Android Developers