หัวข้อหนึ่งที่น่าสนใจในงาน Google I/O 2018 คือ TensorFlow Lite เอนจินสำหรับประมวลผล deep learning ในอุปกรณ์พกพา ที่ทำงานได้ทั้งบน Android, iOS และลินุกซ์

กูเกิลเปิดตัว TensorFlow Lite ตั้งแต่งาน I/O ปี 2017 แต่ตอนนั้นยังไม่ค่อยมีใครเห็นภาพมากนักว่ามันคืออะไร เป้าหมายมีไว้ทำไม แต่เมื่อเวลาผ่านมาอีก 1 ปี ความชัดเจนก็เริ่มตามมา

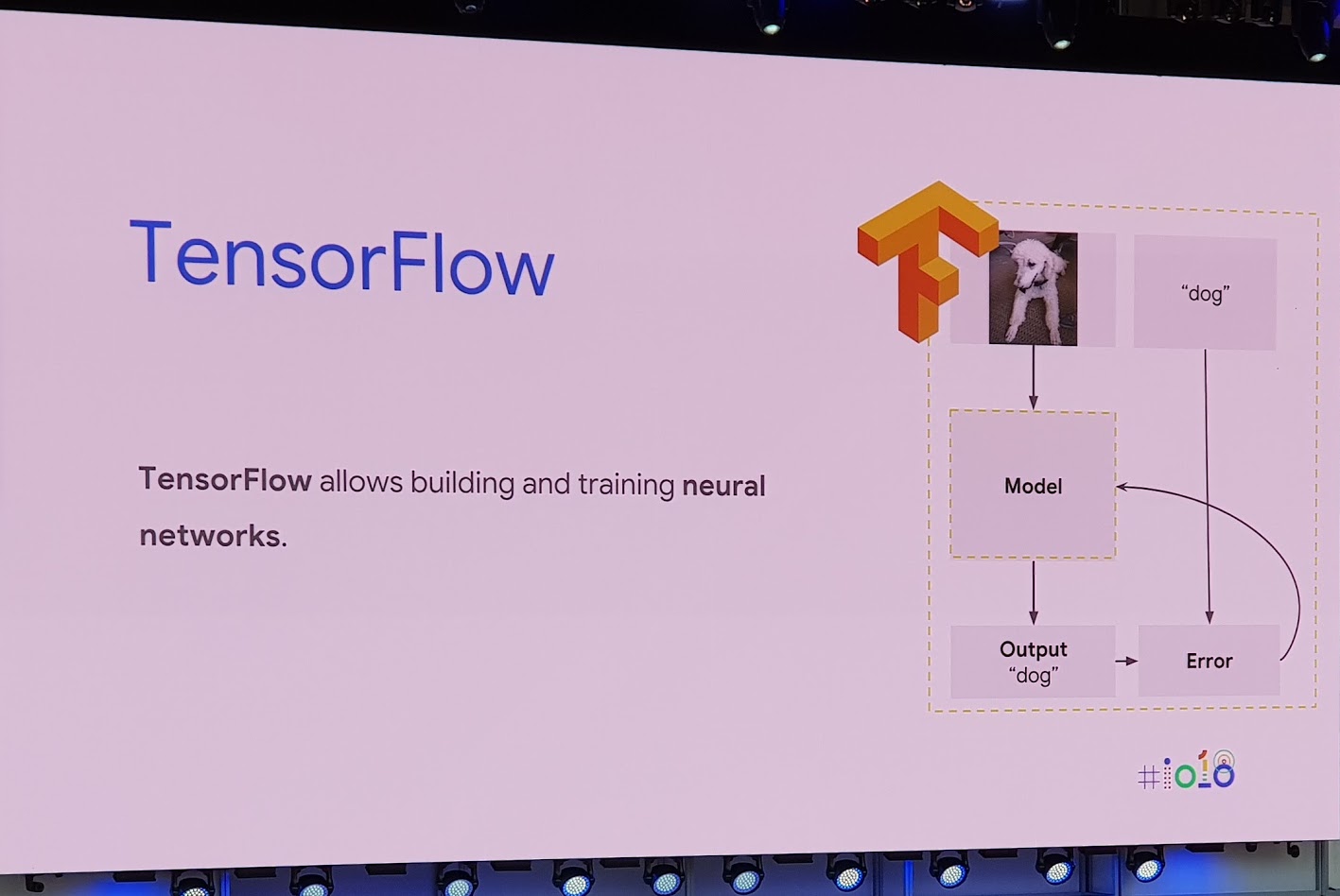

เดิมทีกูเกิลมี TensorFlow สำหรับงาน deep learning อยู่แล้ว แต่มันออกแบบมาเพื่อการใช้งานบนเซิร์ฟเวอร์เป็นหลัก อาจใหญ่เกินไปสำหรับมาใช้งานบนมือถือที่มีทรัพยากรจำกัด

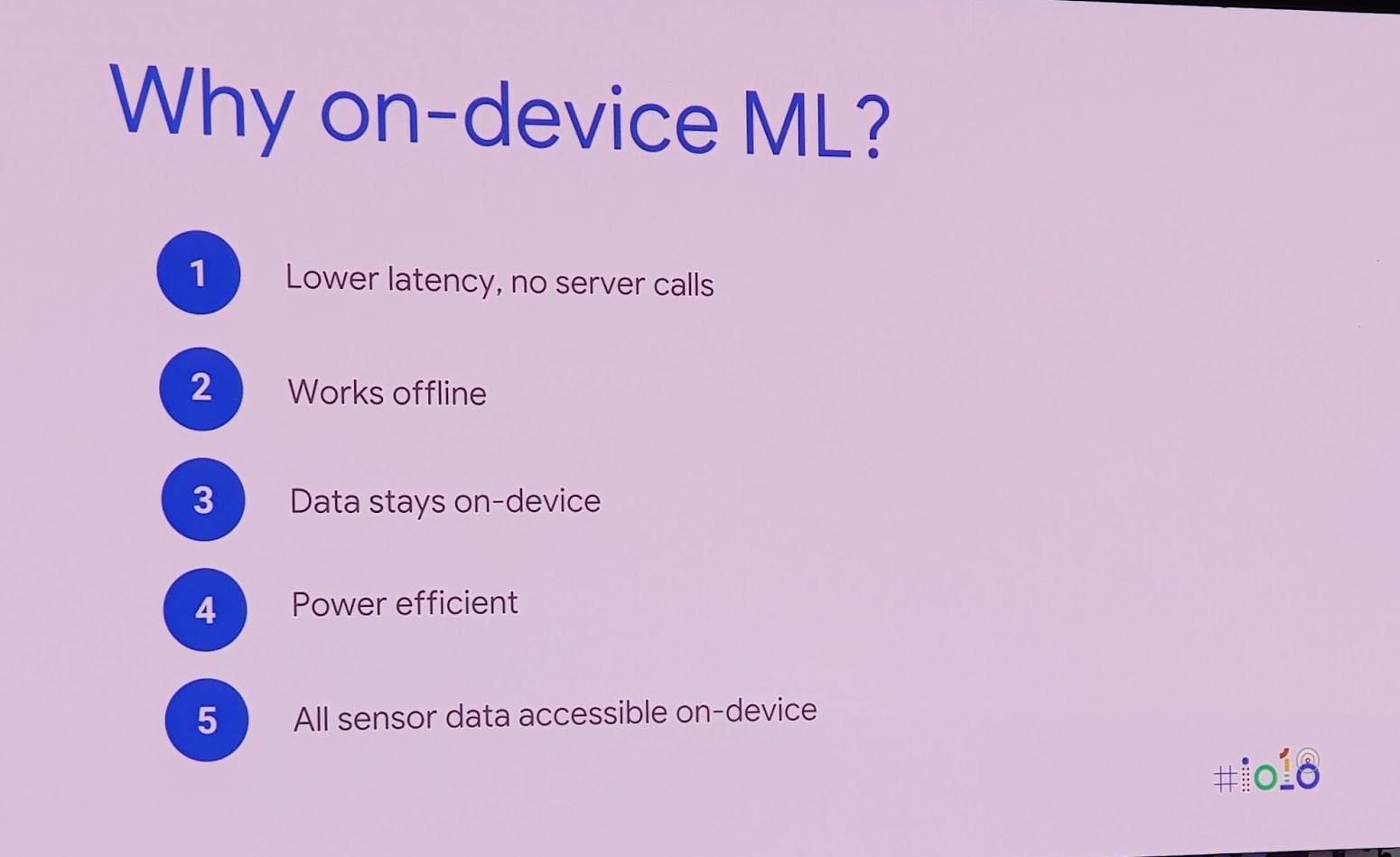

เมื่อพูดถึง deep learning บนมือถือ หลายคนอาจมีคำถามว่าเราต้องการอะไรแบบนั้นจริงๆ หรือ คำตอบคือ deep learning บนมือถือมีประโยชน์หลายอย่าง เช่น ให้ผลรวดเร็วกว่า ทำงานออฟไลน์ได้ เข้าถึงข้อมูลเซ็นเซอร์ได้จากฮาร์ดแวร์โดยตรง

แต่ข้อจำกัดของการรัน deep learning บนมือถือคือ ทรัพยากรมีจำกัดทั้งซีพียูและแรม อีกทั้งเปลืองแบตเตอรี่ด้วย

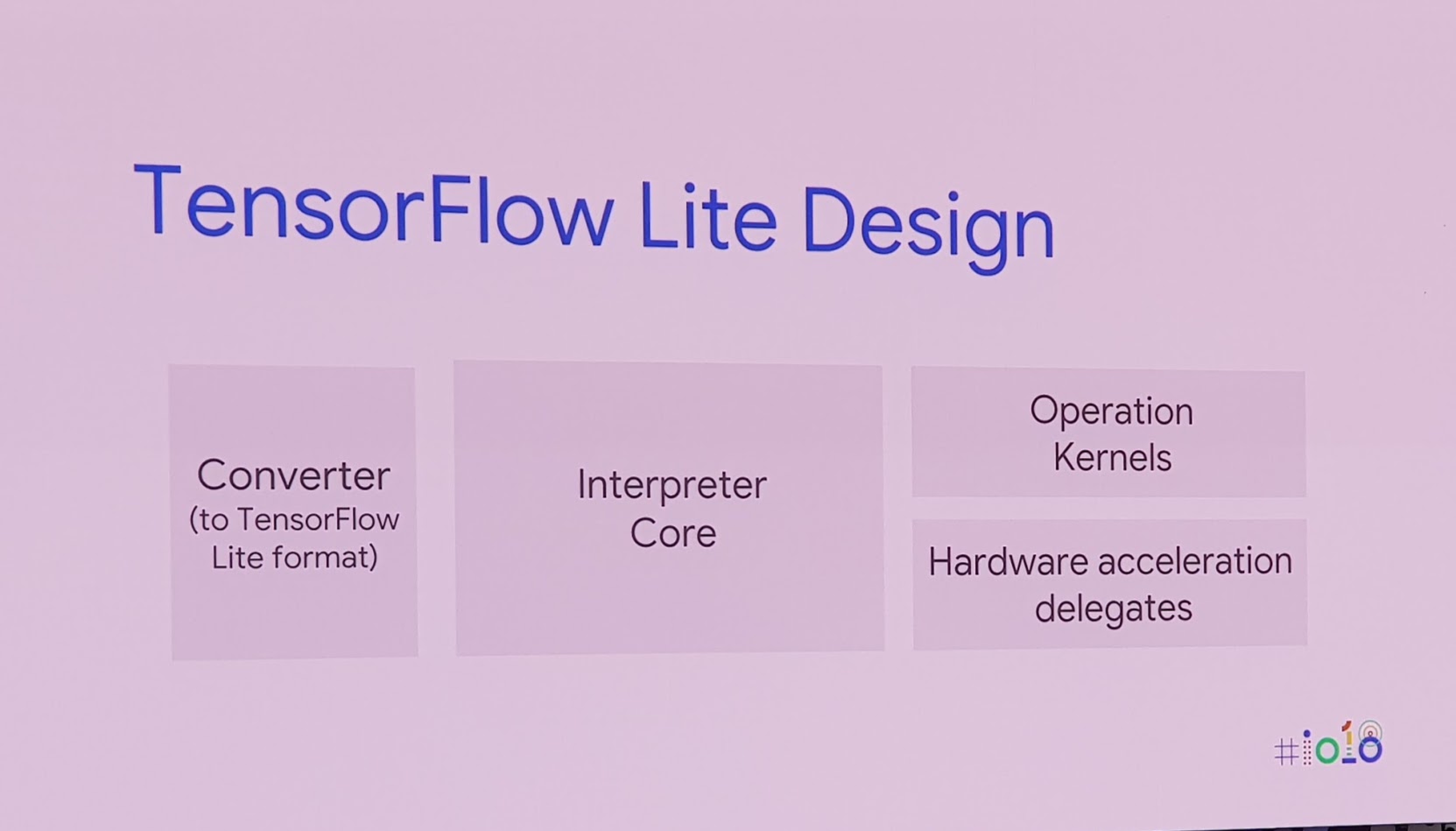

TensorFlow Lite จึงออกแบบมาเพื่อแก้ปัญหานี้ หลักการของมันคือแปลงโมเดลของ TensorFlow ตัวเต็มให้เล็กลง (ความแม่นยำย่อมลดลง แต่อยู่ในระดับที่ยอมรับได้) และ optimize ให้สามารถรันบนอุปกรณ์พกพาได้เป็นอย่างดี สามารถดึงพลังของหน่วยประมวลผล AI ที่ระดับฮาร์ดแวร์ได้ด้วย

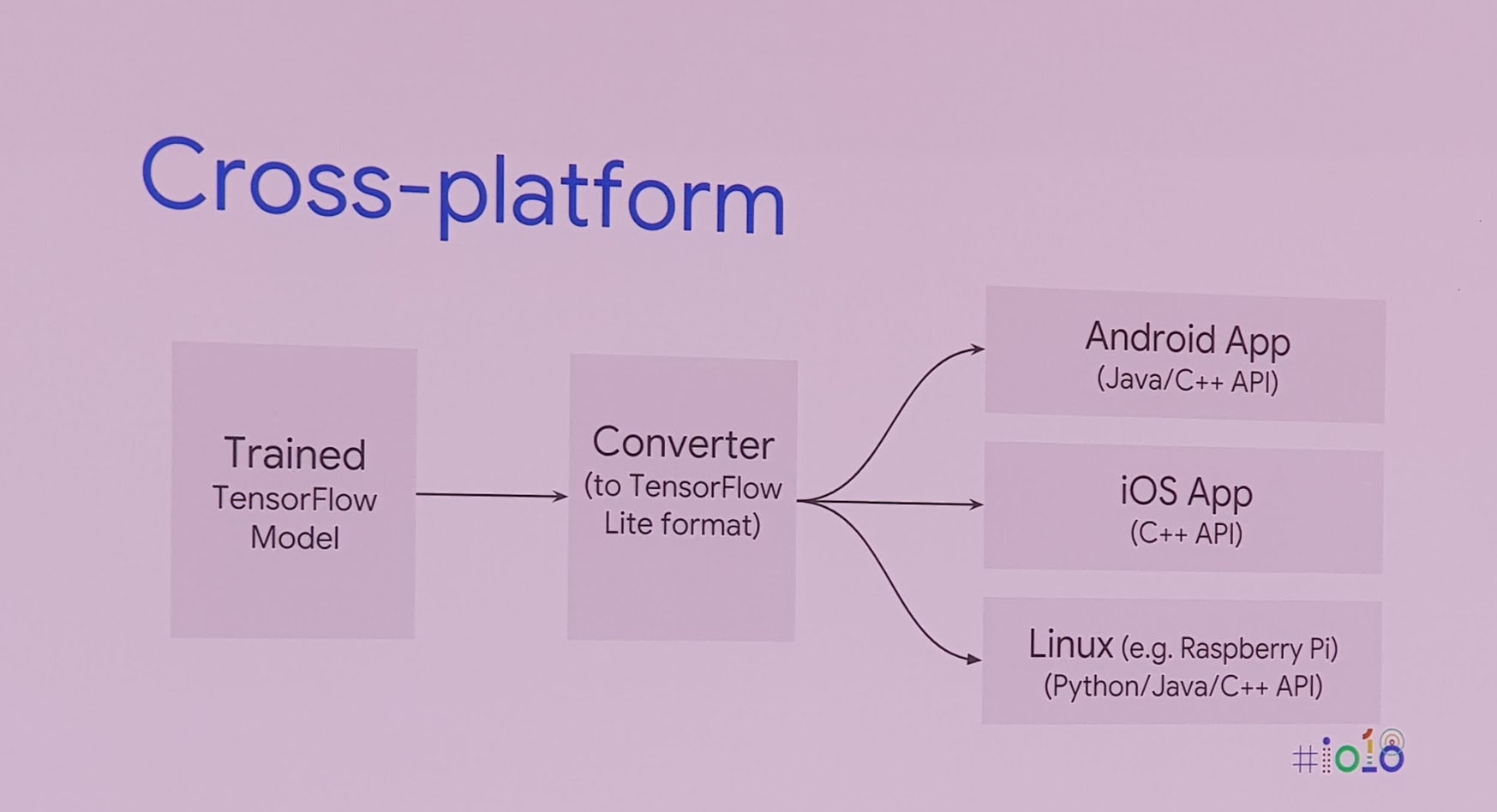

TensorFlow Lite ออกแบบมาให้ทำงานข้ามแพลตฟอร์ม ใช้ได้ทั้งบน Android, iOS และลินุกซ์ นั่นแปลว่าใช้กับอุปกรณ์ IoT ได้ด้วย

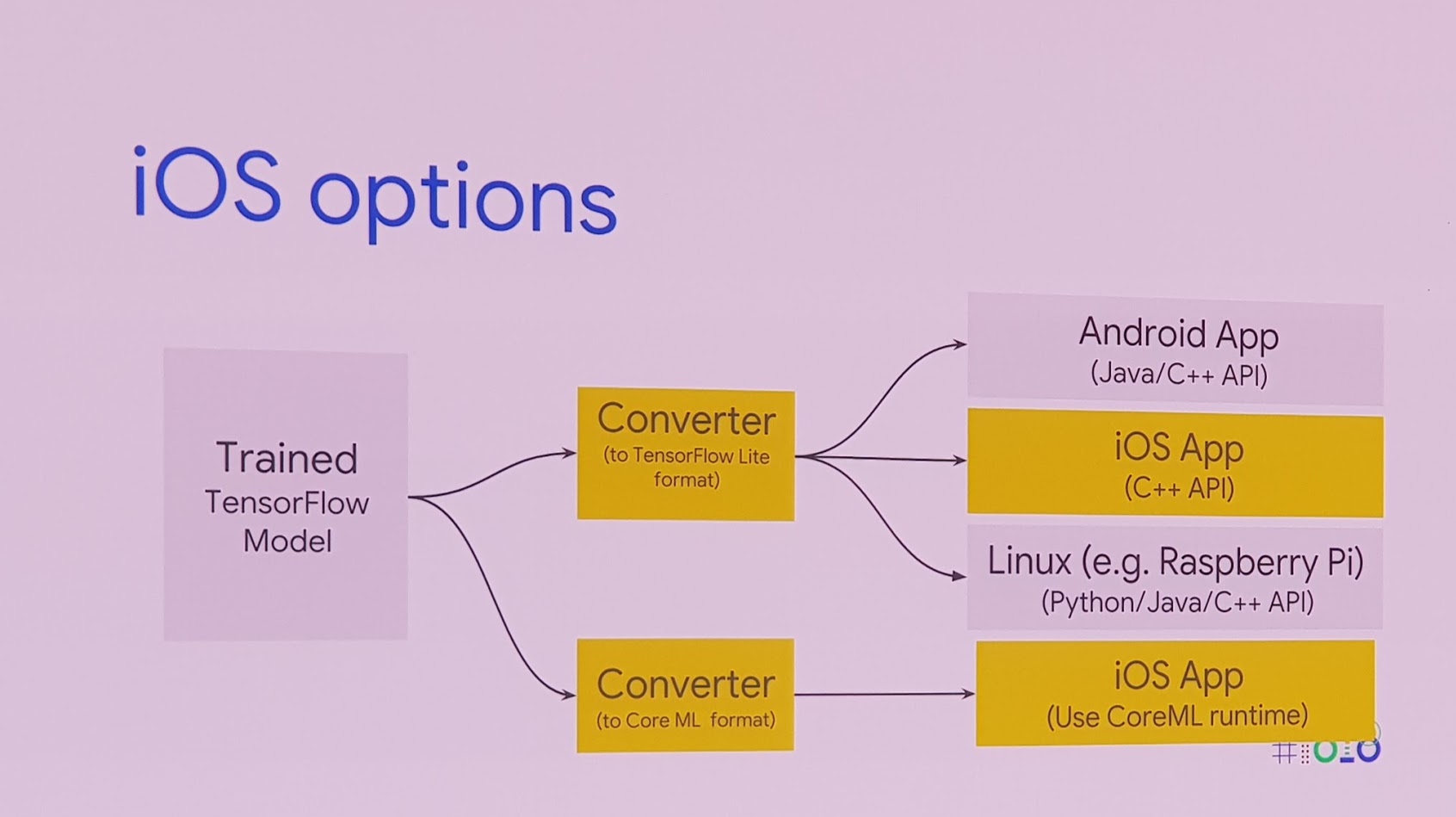

กรณีของ iOS อาจเจอข้อจำกัดจากนโยบายของแอปเปิลบ้าง แต่นักพัฒนาก็เลือกได้ว่าจะรัน TensorFlow Lite แบบเนทีฟ (C++) หรือจะแปลงเป็นฟอร์แมต Core ML ของแอปเปิลก็ได้

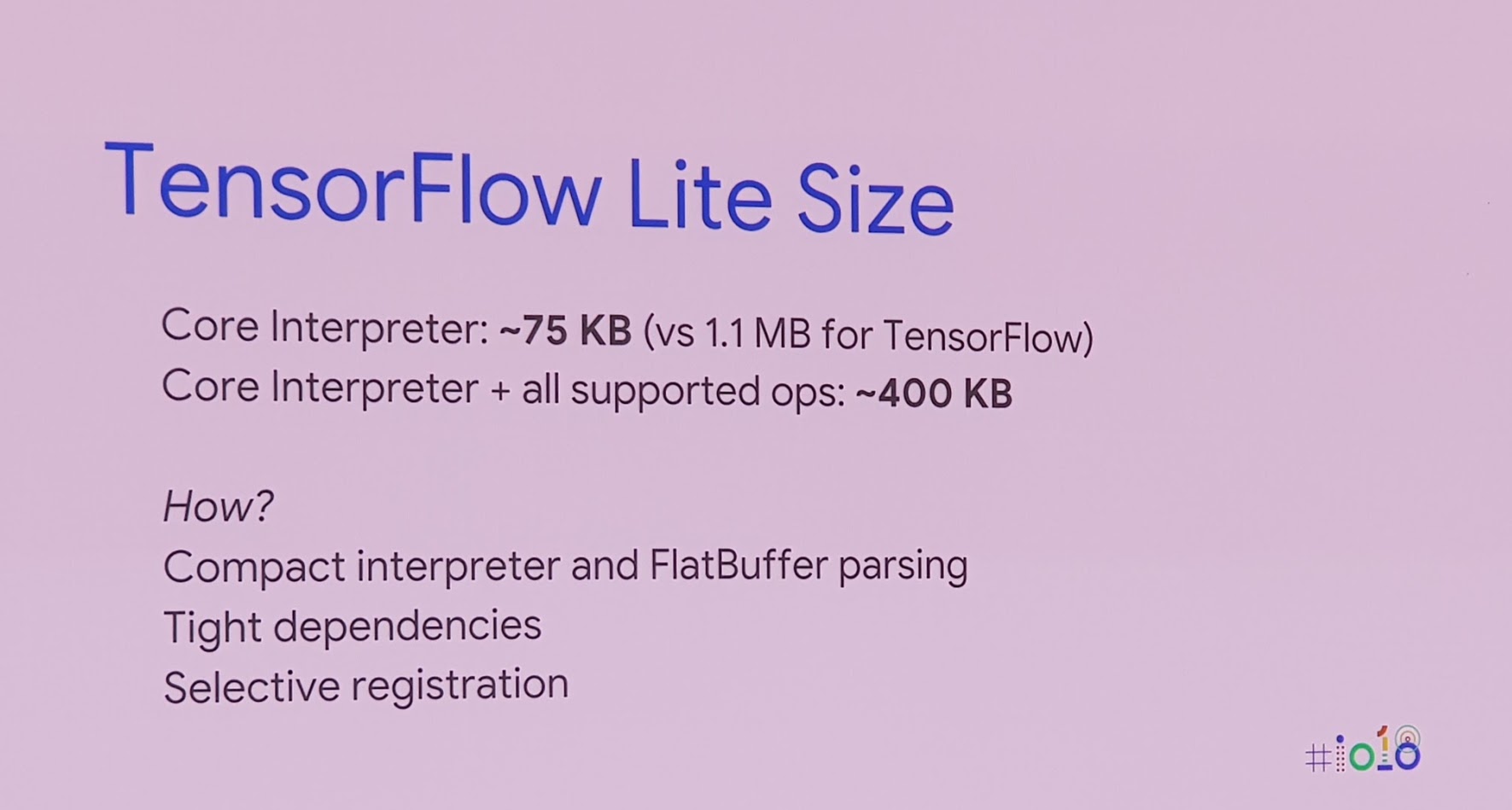

เมื่อถามว่า TensorFlow Lite เล็กแค่ไหน คำตอบคือตัวคอร์ของมันมีขนาดเพียง 75KB เท่านั้น และถ้ารวมส่วนอื่นๆ ด้วยมีขนาดประมาณ 400 KB

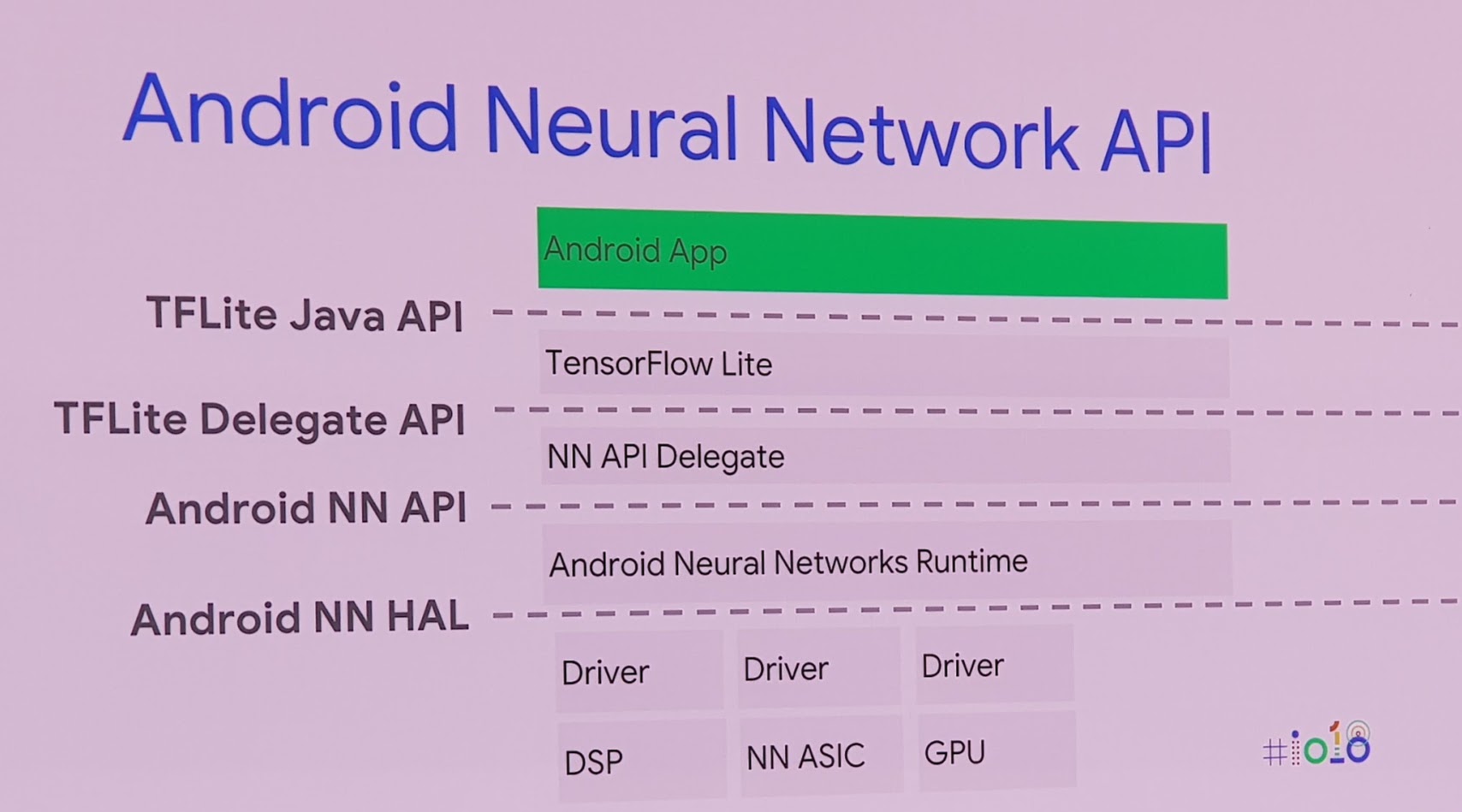

ลำดับชั้นในการเรียกใช้ TensorFlow Lite บน Android คือ แอพจะเรียกใช้งานผ่านเอนจิน TensorFlow Lite ที่ฝังมาในตัวแอพอีกที จากนั้น TensorFlow Lite จะเรียกใช้ฟีเจอร์ Android Neural Networks (Android NN) ของตัว OS ที่เริ่มใส่เข้ามาใน Android 8.1

ลำดับสุดท้าย Android NN จะเรียกใช้ตัวเร่งการประมวลผลที่ระดับฮาร์ดแวร์ (ถ้ามี เช่น ของ ARM) หรือรันบน CPU/GPU ตามสถานการณ์ที่แตกต่างกันไป

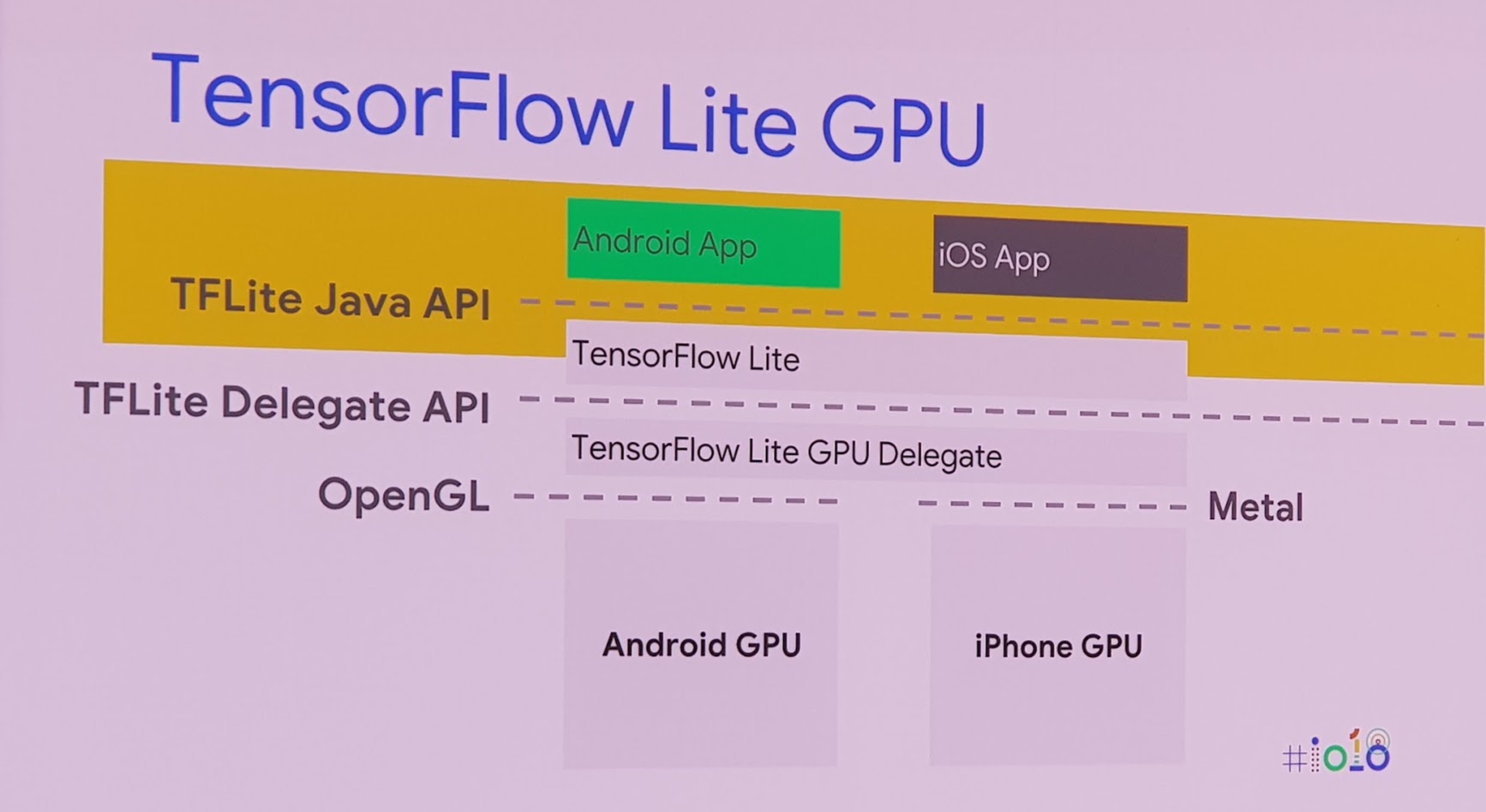

ในกรณีของ iOS ที่ไม่มีชิปเร่งความเร็ว AI แยกเฉพาะ (หรือมีก็โดนกั๊กไว้ไม่ให้รัน) นักพัฒนาสามารถรันบน GPU ผ่าน Metal API ได้ตามปกติ

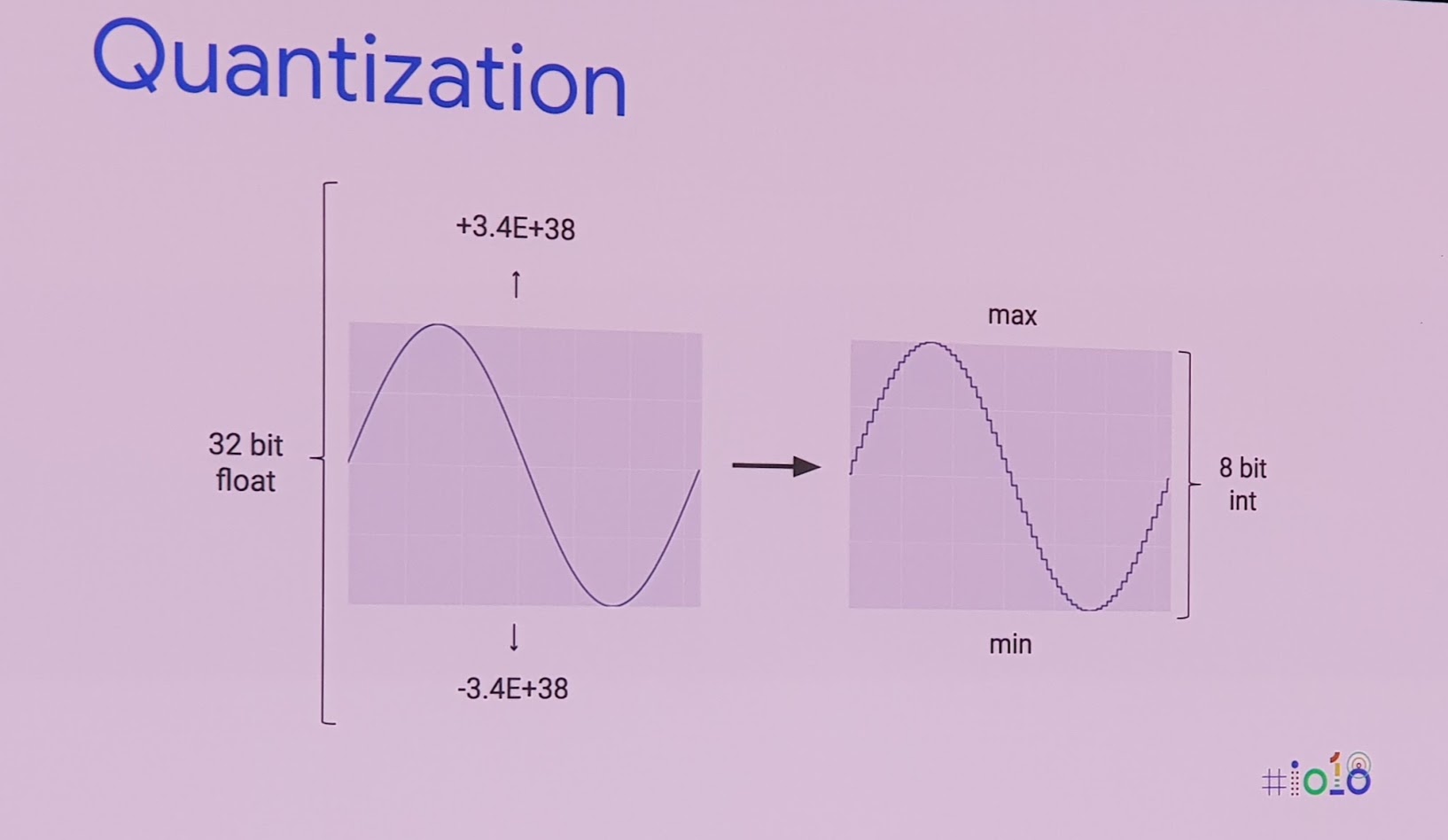

เทคนิคหนึ่งในการลดขนาดโมเดลที่กูเกิลนำมาใช้งานคือ quantization ลดความละเอียดของสัญญาณข้อมูลลง แต่ยังรักษาโครงสร้างเดิมเอาไว้

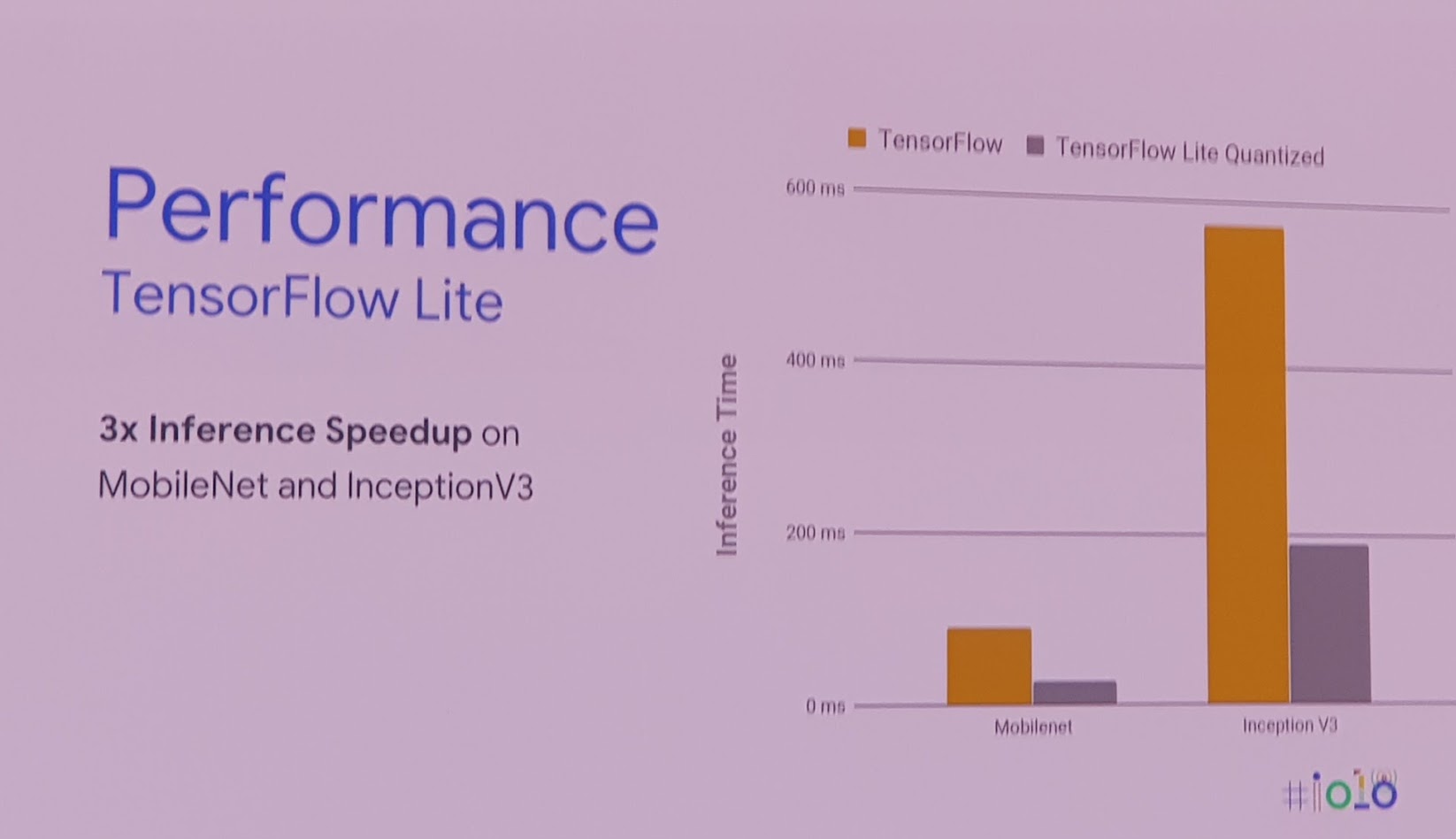

ผลของการทำ quantization ทำให้ TensorFlow Lite ทำงานได้เร็วกว่า TensorFlow ตัวเต็มถึง 3 เท่า และกราฟนี้ยังไม่ได้ใช้ฮาร์ดแวร์ AI ช่วยเร่งการทำงาน ถ้าเปิดใช้ก็น่าจะลดระยะลงได้อีก 3-4 เท่า

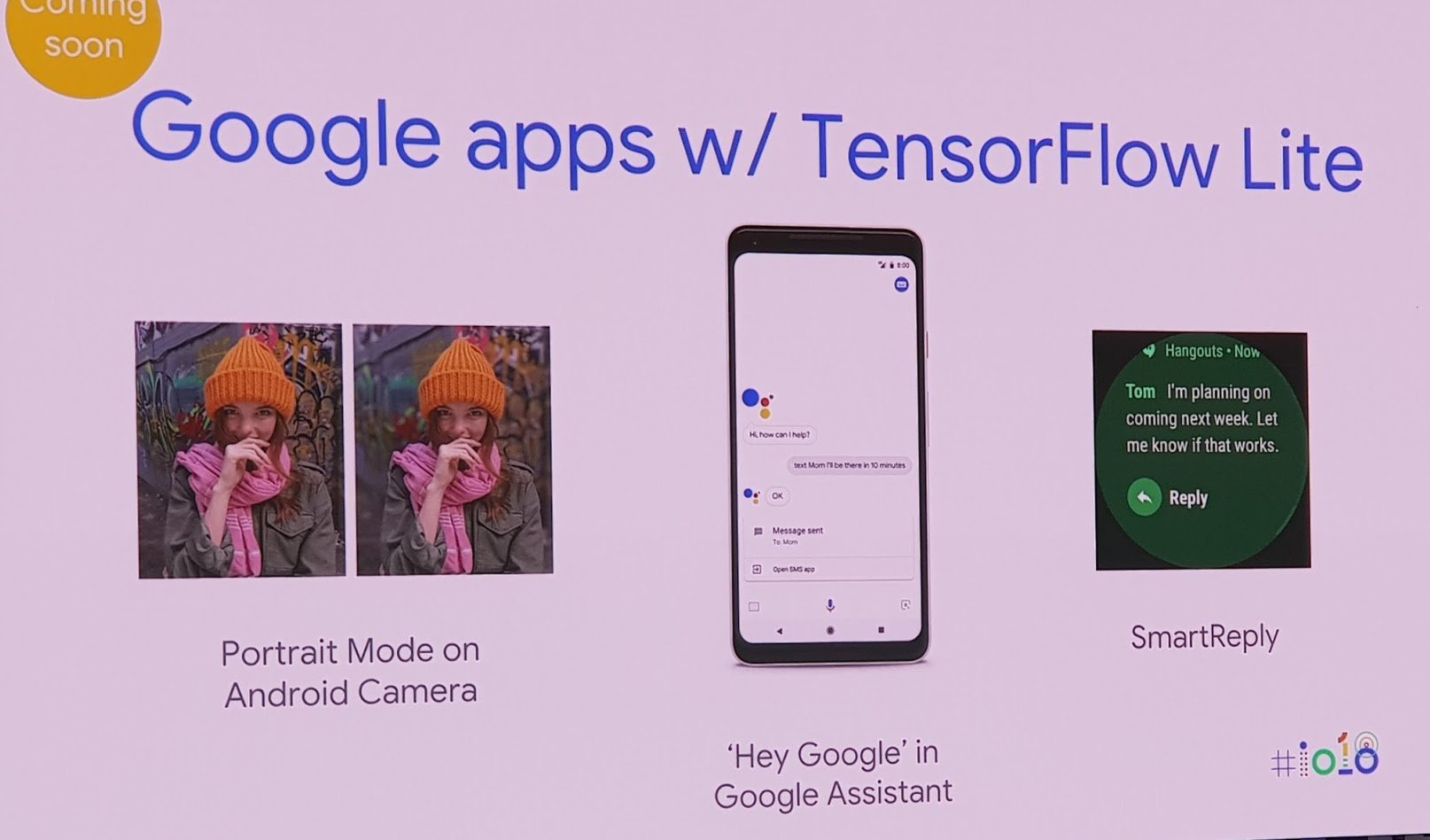

ตอนนี้เริ่มมีแอพของกูเกิลบางตัว เรียกใช้งาน TensorFlow Lite แล้ว เช่น แอพกล้องของ Android ที่มี Portrait Mode, ฟีเจอร์สั่งงานด้วยเสียงของ Google Assistant และฟีเจอร์ Smart Reply ช่วยเขียนคำตอบข้อความให้อัตโนมัติ

ส่วนนักพัฒนาแอพอื่นๆ ก็สามารถเรียกใช้ฟีเจอร์ deep learning เหล่านี้ได้ผ่าน ML Kit ซึ่งเป็นบริการตัวหนึ่งของ Firebase

แอพที่เริ่มเรียกใช้งาน ML Kit แล้วก็อย่างเช่น แอพแต่งภาพ PicsArt และแอพกล้อง VSCO

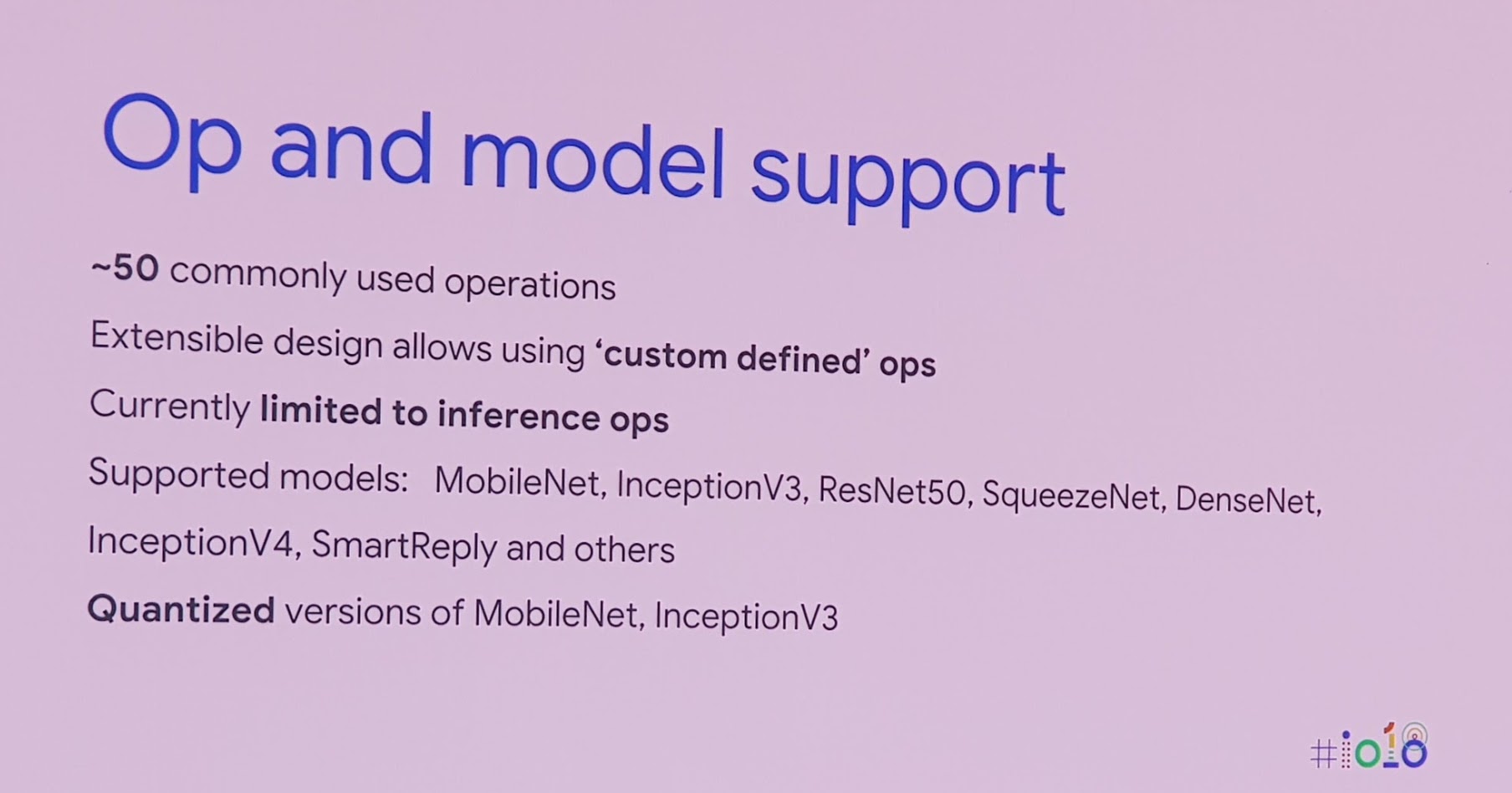

ตอนนี้ TensorFlow Lite ยังรองรับโมเดลเพียงบางประเภท แต่แผนการพัฒนาก็จะรองรับโมเดลชนิดใหม่ๆ มากขึ้น รวมถึงจะสามารถ "เทรน" โมเดลบนมือถือได้ในอนาคตด้วย (ปัจจุบันรันโมเดลได้อย่างเดียว)

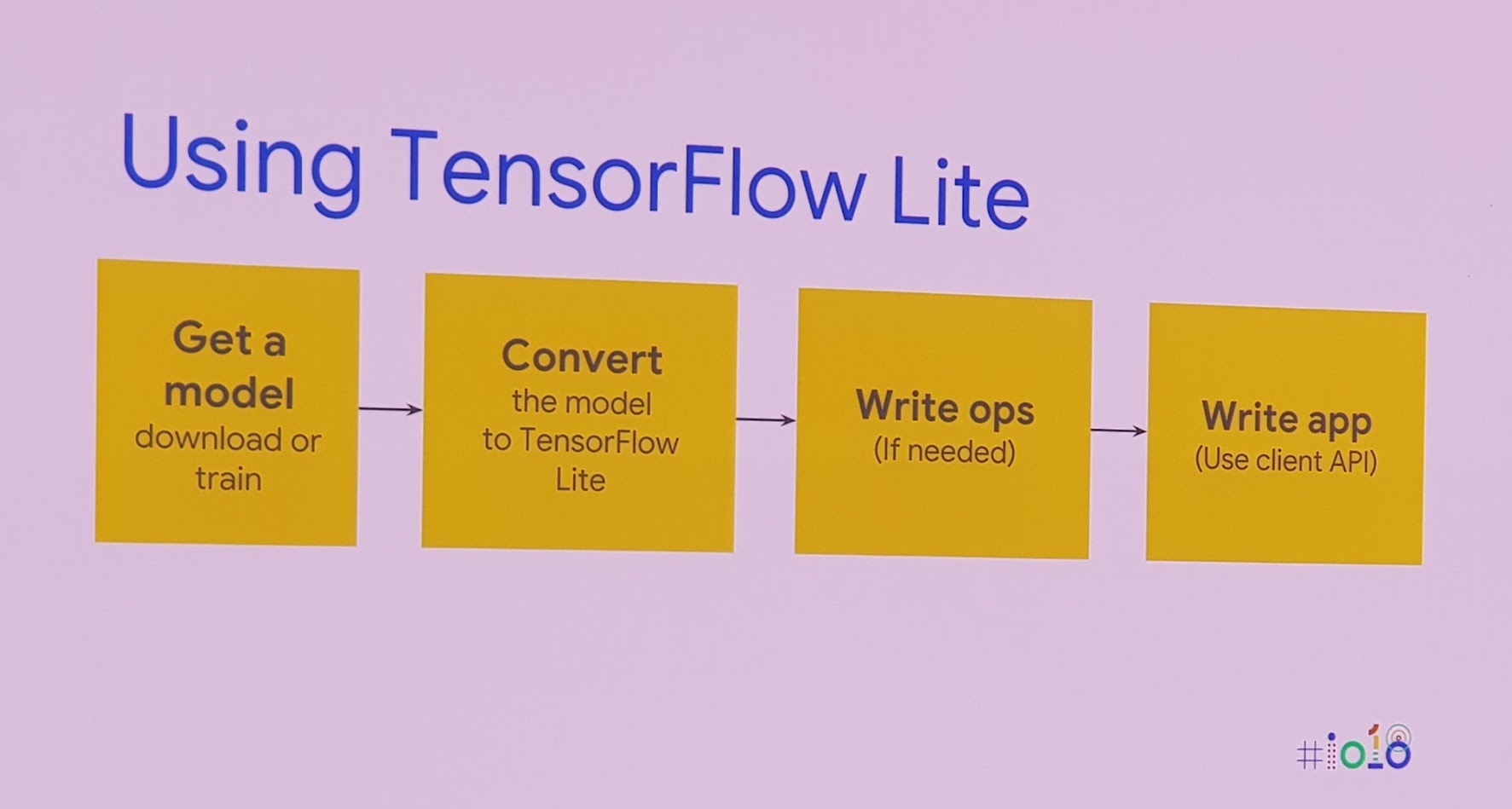

ขั้นตอนการใช้งาน TensorFlow Lite หลักๆ เลยคือการนำโมเดล TensorFlow ที่เทรนไว้แล้ว (ไม่ว่าจะเทรนเอง หรือดาวน์โหลดอันที่คนอื่นเทรนมาให้) มาแปลงเป็นโมเดลของ TensorFlow Lite แล้วจากนั้นค่อยเรียกใช้งานในแอพอีกทีหนึ่ง

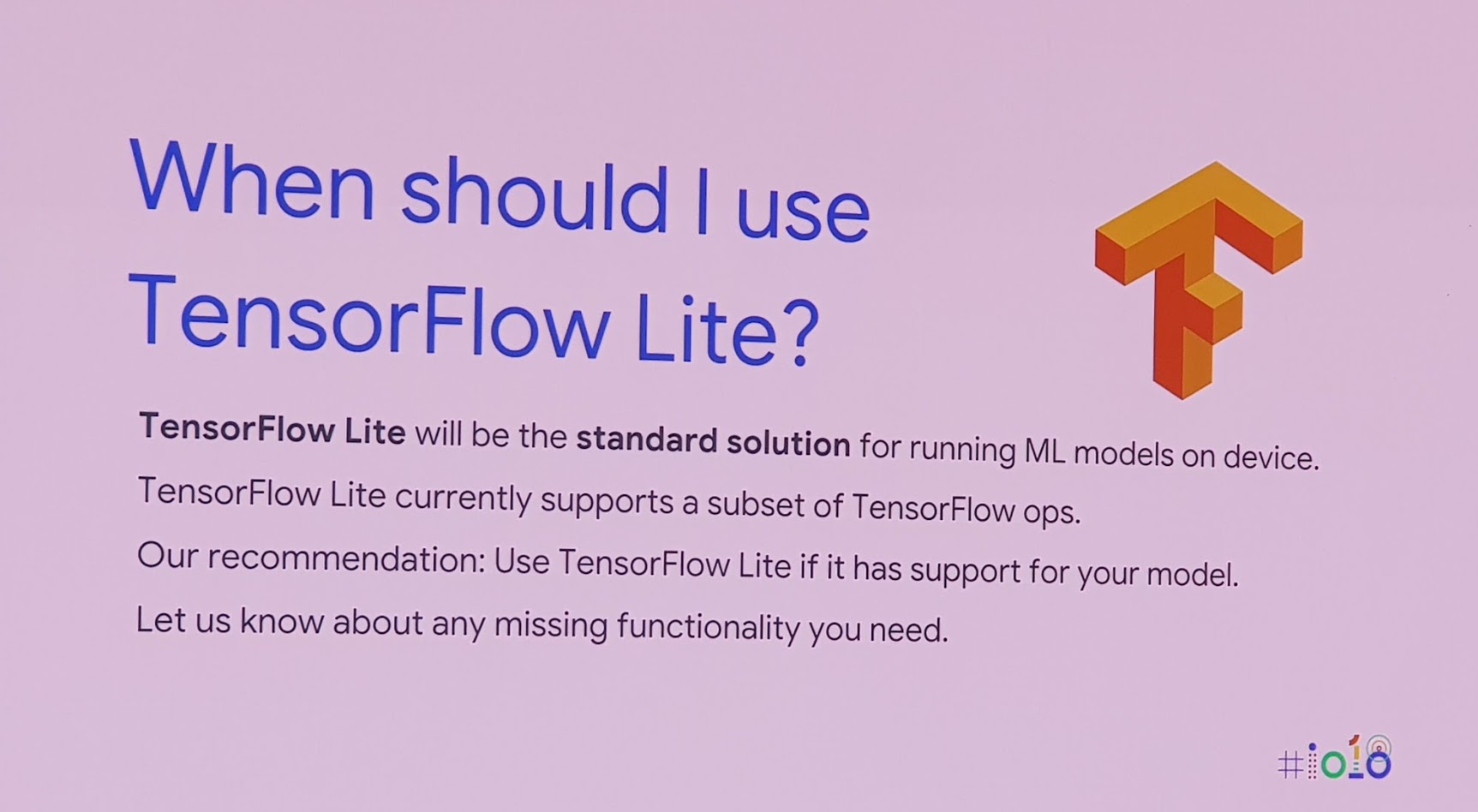

กูเกิลระบุว่า TensorFlow Lite จะกลายเป็นเครื่องมือมาตรฐานในการรัน machine learning บนมือถือ ยังไงก็หนีไม่พ้น แต่ตอนนี้ยังมีข้อจำกัดเรื่องการรองรับโมเดลเพียงบางประเภท คำแนะนำก็คือพิจารณาก่อนใช้งานว่า TensorFlow รองรับโมเดลที่เราต้องใช้หรือไม่

รายละเอียดสามารถดูได้จากวิดีโอหัวข้อ TensorFlow Lite for mobile developers ของงาน Google I/O 2018 (ตอนนี้ยังไม่ขึ้น YouTube ถ้าขึ้นแล้วจะมาแปะตรงนี้อีกรอบครับ)

Comments

คลิปย้อนหลังครับ TensorFlow Lite for mobile developers (Google I/O '18)

ขอบคุณครับ เพิ่มในบทความให้แล้ว