NVIDIA มีซอฟต์แวร์ชื่อ TensorRT สำหรับรีดประสิทธิภาพ (optimization) ของการรันโมเดล deep learning ที่พัฒนามาได้สักระยะหนึ่งแล้ว ล่าสุด NVIDIA เปิดให้นักพัฒนาสามารถดาวน์โหลด TensorRT 2.0 ไปใช้งานกัน

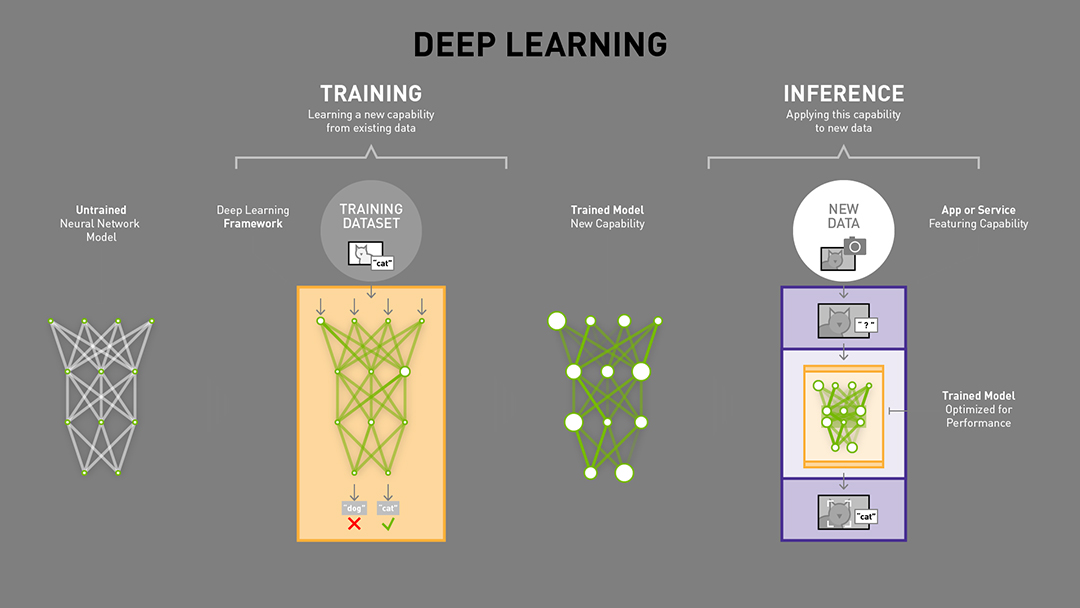

ปกติแล้วในโลกของ AI เราแยกงานของการเทรนหรือสร้างโมเดล (training) และการนำโมเดลไปใช้งาน (interference) ออกจากกัน

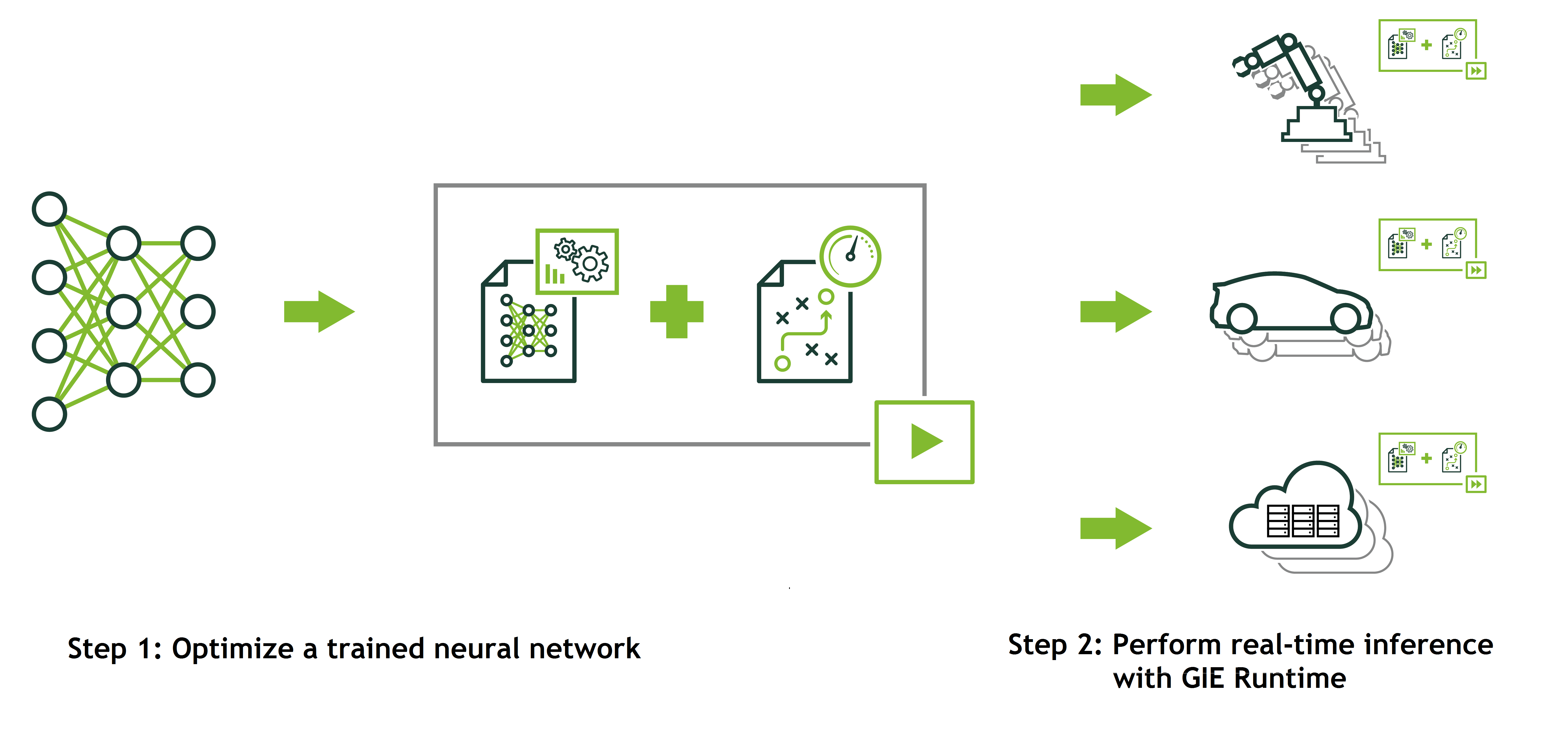

แนวคิดของ TensorRT คือการรีดประสิทธิภาพในตอนรัน (RT = runtime) ให้มีประสิทธิภาพสูงสุด มันออกแบบมาสำหรับปรับแต่งประสิทธิภาพก่อน เพื่อตอนรันงานจริง (production) จะได้ใช้งานทรัพยากรเครื่องอย่างคุ้มค่าที่สุด (เทคนิคจะคล้ายกับการแปลง bytecode ของ Java หรือการคอมไพล์แบบ ahead-of-time)

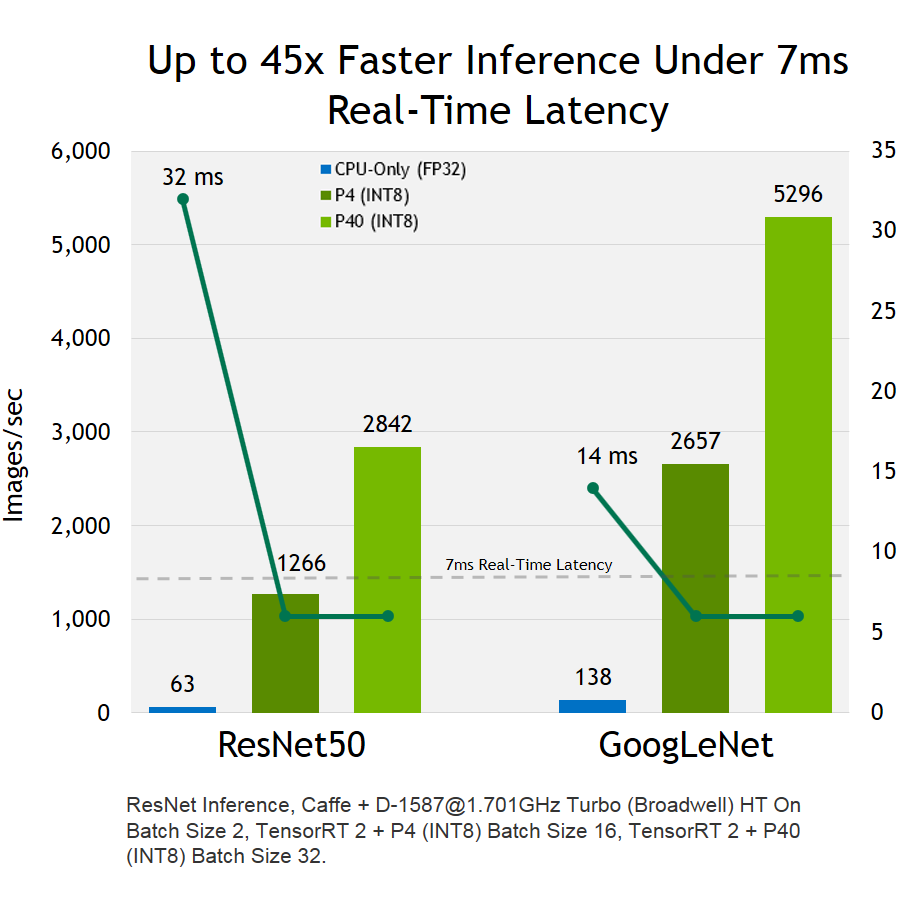

NVIDIA คุยว่า TensorRT 2.0 สามารถเร่งความเร็วของการรันโมเดลได้มากถึง 45 เท่า เมื่อเทียบกับการรันโมเดลด้วยซีพียูเพียงอย่างเดียว

ในโอกาสเดียวกัน NVIDIA ยังประกาศพัฒนา TensorRT 3.0 ต่อแล้ว โดยมันจะออกแบบมาสำหรับจีพียูสถาปัตยกรรม Volta ตัวต่อไปโดยเฉพาะ และสามารถเร่งประสิทธิภาพได้ดีขึ้น 3.5 เท่า เมื่อเทียบกันระหว่าง Tesla V100 (Volta) กับ Tesla P100 (Pascal)

ฟีเจอร์อื่นๆ ยังรวมถึงการนำโมเดลจาก Caffe, TensorFlow มาใช้งาน และการรองรับแพลตฟอร์ม Android, QNX ด้วย

ภาพจาก NVIDIA Facebook

ภาพจาก NVIDIA

ภาพจาก NVIDIA

ภาพจาก NVIDIA