ทุกวันนี้ระบบปัญญาประดิษฐ์สำหรับประมวลผลภาษา (natural language processing - NLP) ตัวที่ดีที่สุดคือ BERT เสนอโดยกูเกิลเมื่อปลายปี 2018 แม้ประสิทธิภาพจะค่อนข้างดีจนกูเกิลนำมาใช้ในบริการค้นหาแล้ว แต่ปัญหาของ BERT คือมีขนาดใหญ่มาก โมเดลเริ่มต้นมีขนาด 108 ล้านพารามิเตอร์และขนาด xlarge นั้นขึ้นไปถึง 1,270 ล้านพารามิเตอร์ ปีนี้ทีมวิจัยกูเกิลเสนอโมเดล ALBERT ที่เป็นโมเดลขนาดเล็กลง แต่ยังคงประสิทธิภาพที่ใกล้เคียงกัน โดยเฉพาะ ALBERT ในขนาดใหญ่สุด 235 ล้านพารามิเตอร์นั้นประสิทธิภาพดีกว่า BERT ในทุกการทดสอบ

ทีมวิจัยสังเกตพบว่าเน็ตเวิร์คของปัญญาประดิษฐ์มักทำงานคล้ายๆ กันในแต่ละชั้นของโมเดล จึงออกแบบโครงสร้างใหม่ที่แต่ละชั้นแชร์พารามิเตอร์กัน 90% ทำให้โมเดลพื้นฐานของ ALBERT มีขนาดเพียง 12 ล้านพารามิเตอร์เท่านั้น เล็กว่า BERT ถึง 89%

ตัวอย่างหนึ่งของการทดสอบ คือ ชุดทดสอบ RACE ที่เป็นการทดสอบความเข้าในเนื้อหา คะแนนเต็ม 95 นั้น BERT เคยทำได้ 72 คะแนน ขณะที่โมเดลในช่วงหลังใช้ข้อมูลฝึกเพิ่มเติม เช่น RoBERTa ได้ 83.2 คะแนน เมื่อทีมวิจัยนำ ALBERT ขนาดใหญ่สุด (235 ล้านพารามิเตอร์) มาฝึกด้วยชุดข้อมูลของ RoBERTa สามารถทำคะแนนได้ถึง 89.4 คะแนน

กูเกิลเปิดซอร์ส ALBERT ไว้ใน GitHub

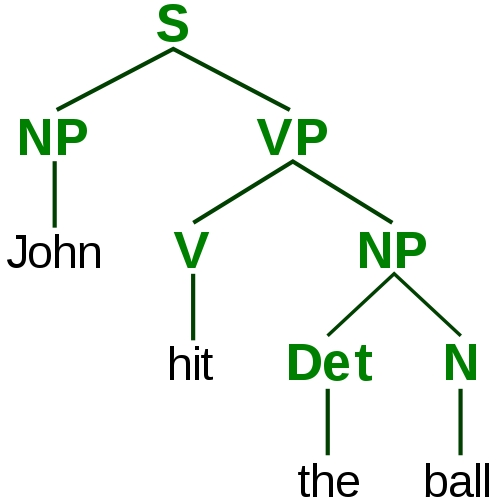

แผนภาพการแยกส่วนประกอบของประโยค ภาพโดย Stannered