ศูนย์วิจัยโมเดล AI ของมหาวิทยาลัยสแตนฟอร์ด (Center for Research on Foundation Models หรือ CRFM) ร่วมกับหน่วยงานวิจัยของ MIT Media Lab และ Princeton เปิดตัวดัชนีความโปร่งใสของโมเดล AI ที่เรียกว่า Foundation Model Transparency Index

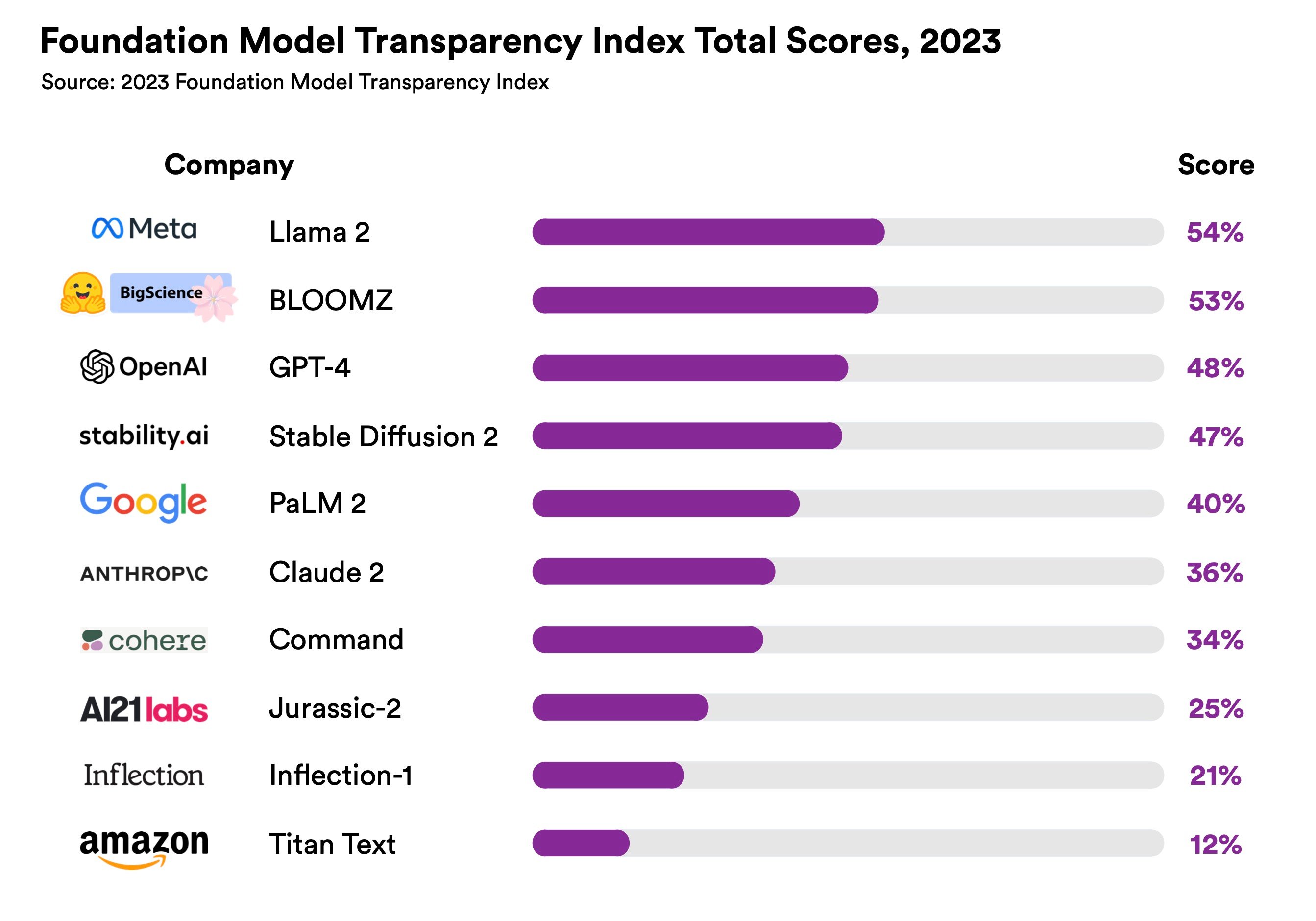

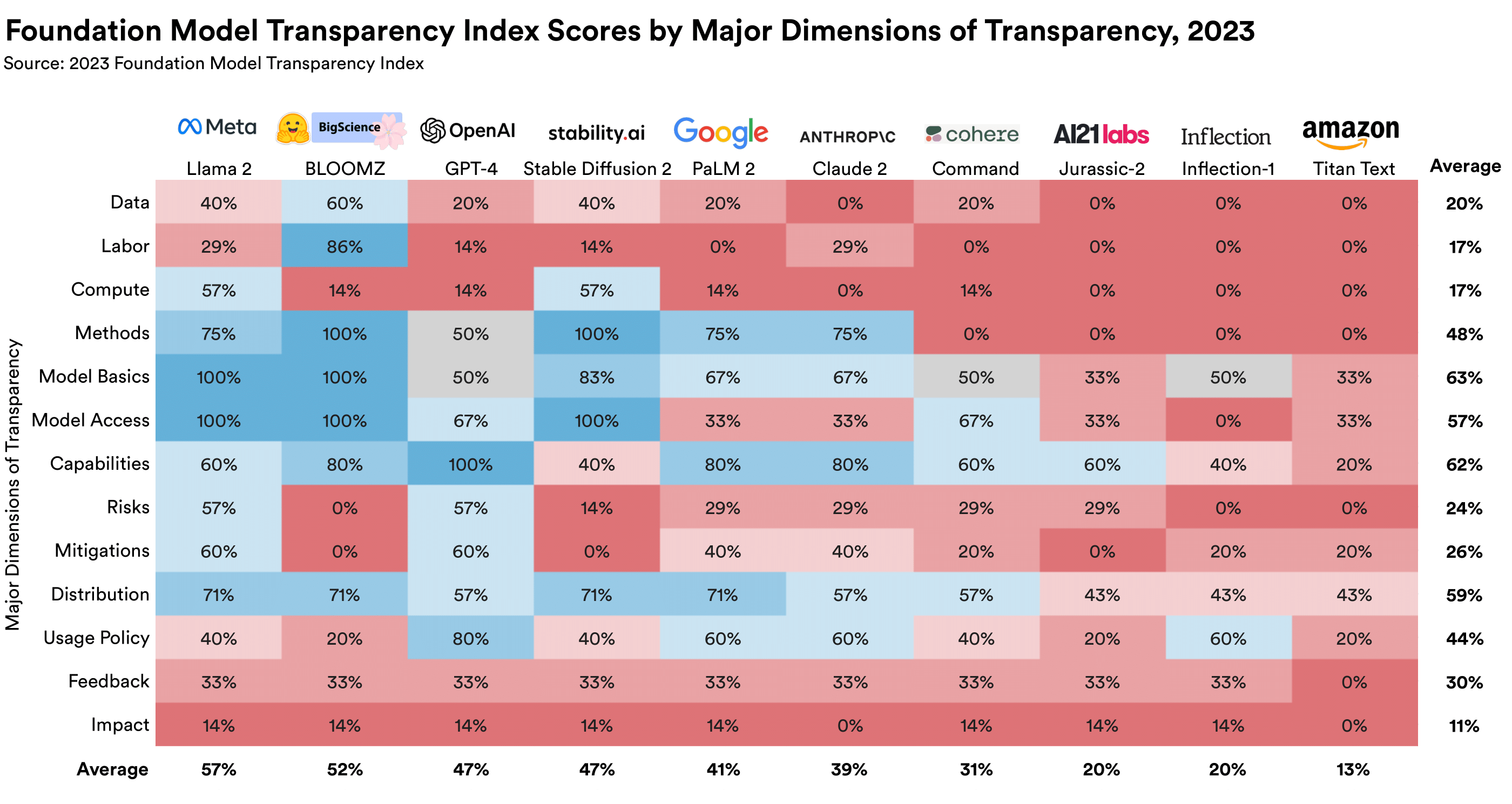

ดัชนี Foundation Model Transparency Index ให้คะแนนโมเดล AI ขนาดใหญ่ของบริษัทต่างๆ ในเรื่องความโปร่งใสของกระบวนการสร้างโมเดล เริ่มตั้งแต่ข้อมูลที่ใช้เทรน การจ้างแรงงานเพื่อแปะป้ายให้ข้อมูลที่เทรน ความโปร่งใสของตัวโมเดล ความเสี่ยงในการใช้งาน มาตรการความปลอดภัย ฯลฯ รวม 13 หมวด

ผลออกมาว่าโมเดล Llama 2 ของ Meta ได้คะแนนอันดับหนึ่ง 54/100 จากปัจจัยการเป็นโมเดลโอเพนซอร์ส ส่วน GPT-4 ของ OpenAI อยู่อันดับสามที่คะแนน 47/100 โดยทำคะแนนหมวดความสามารถ (capabilities) ได้สูงสุด

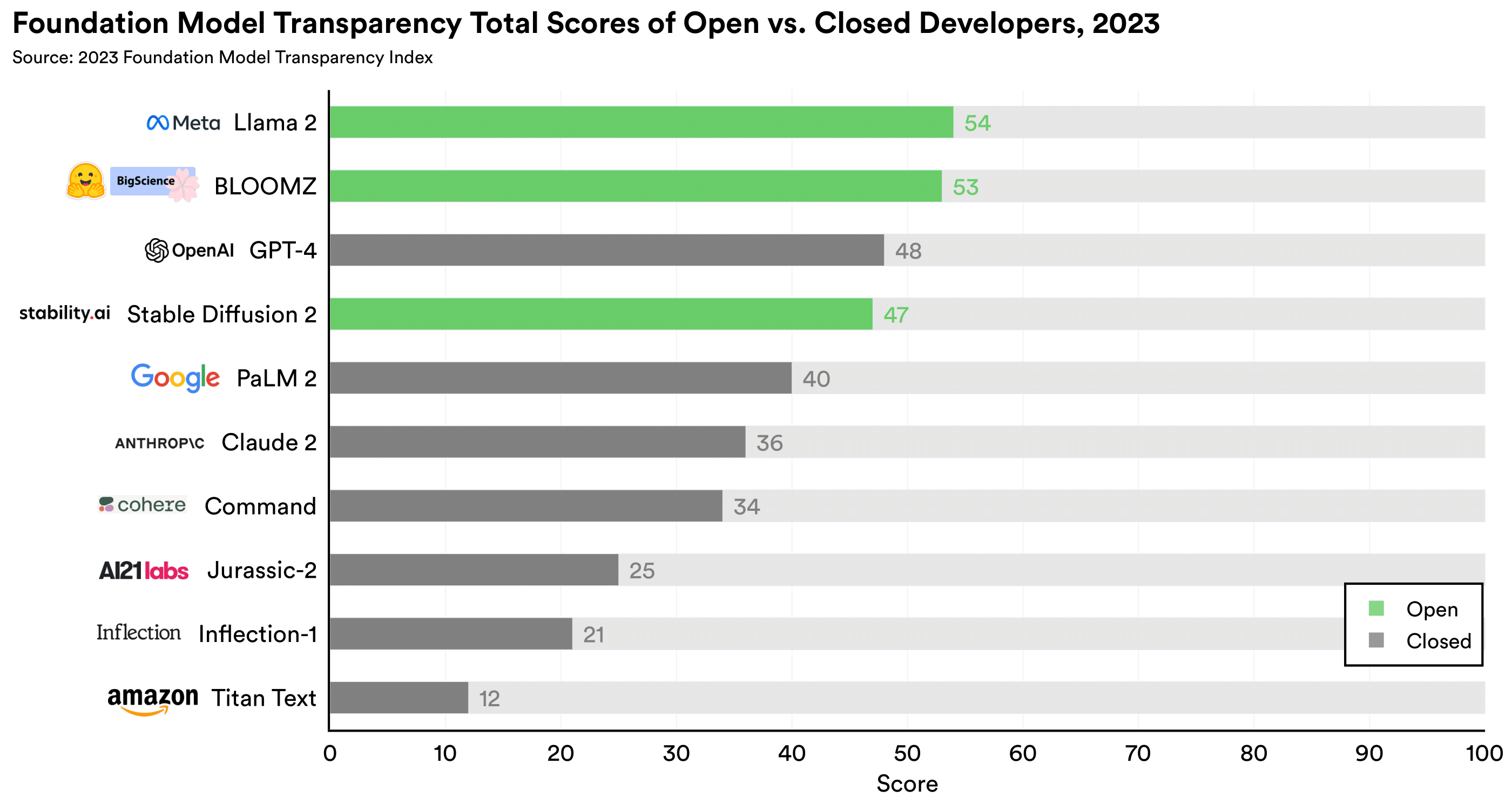

โมเดลที่เป็นโอเพนซอร์สล้วนทำคะแนนได้ค่อนข้างดี เพราะมีคะแนนความโปร่งใสของตัวโมเดลสูง โดย Llama 2 อยู่อันดับหนึ่ง, BLOOMZ ของ Hugging Face อันดับสอง และ Stable Diffusion 2 อยู่อันดับสี่

คณะผู้วิจัยบอกว่าความโปร่งใสของโมเดลเป็นเรื่องสำคัญมากขึ้นเรื่อยๆ เพราะบริษัทต่างๆ เริ่มปกปิดข้อมูลโมเดลของตัวเอง ตัวอย่างสำคัญคือ OpenAI แม้มีคำว่า Open อยู่ในชื่อแต่ก็ไม่ Open จริงๆ และ GPT-4 เปิดเผยข้อมูลต่อสาธารณะน้อยกว่าโมเดลรุ่นก่อนๆ มาก

การมีดัชนีกลางวัดค่าความโปร่งใส ย่อมช่วยให้ลูกค้าหรือผู้ที่นำโมเดลเหล่านี้ไปใช้งานมีความมั่นใจในตัวโมเดลมากขึ้น แม้โมเดลที่ได้คะแนนสูงสุดยังได้เพียง 54 เต็ม 100 เท่านั้น แปลว่าในโลก AI ยังมีสิ่งที่ปรับปรุงเพื่อยกระดับความโปร่งใสได้เพิ่มอีกมาก ตัวดัชนีเองเปิดเผยเปเปอร์เบื้องหลังความยาว 100 หน้าและข้อมูลทั้งหมดที่ใช้งานด้วย

ที่มา - Stanford