DeepMind เปิดตัวปัญญาประดิษฐ์สถาปัตยกรรมใหม่สำหรับการทำความเข้าใจภาษามนุษย์ โดยทดสอบสถาปัตยกรรมนี้หลายขนาด ตั้งแต่ 44 ล้านพารามิเตอร์ไปจนถึง 280,000 ล้านพารามิเตอร์ โดยตั้งชื่อโมเดลใหญ่ที่สุดนี้ว่า Gopher ซึ่งใหญ่กว่าโมเดล GPT-3 ของ OpenAI ถึง 60%

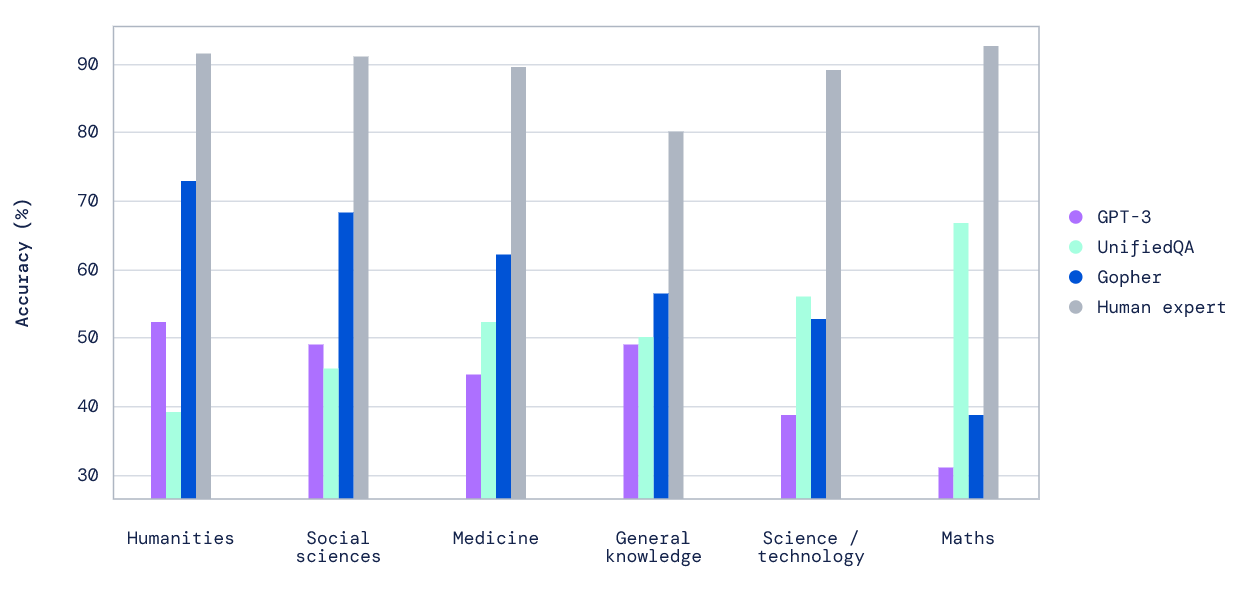

Gopher ทำคะแนนทดสอบความเข้าใจภาษา (Massive Multitask Language Understanding - MMLU) ได้เหนือกว่า GPT-3 แทบทุดหมวด บางหมวดเช่นมนุษยศาสตร์นั้นเริ่มเข้าใกล้คนจริงๆ (คะแนนสูงกว่า 70 คะแนนเทียบกับมนุษย์ที่ได้ประมาณ 90 คะแนน)

ทาง DeepMind ยกตัวอย่างบทสนทนาถามตอบเรื่องเซลล์ ตัว Gopher สามารถตอบคำถามได้อย่างตรงประเด็น ได้ใจความ แต่ขณะเดียวกันก็รายงานปัญหาว่า Gopher นั้นไม่สามารถแสดงความไม่แน่ใจเวลาที่หาคำตอบไม่ได้ แต่กลับให้คำตอบอย่างผิดๆ ออกมาแทน

งานวิจัยครั้งนี้ DeepMind ออกรายงานถึงความเสี่ยงของโมเดลปัญญาประดิษฐ์ด้านภาษาขนาดใหญ่ออกมาพร้อมกัน โดยระบุความเสี่ยง 6 ด้าน ได้แก่

- ปัญญาประดิษฐ์ใช้ภาษาเหยียด

- ตัวปัญญาประดิษฐ์ทำข้อมูลหลุด

- ปัญญาประดิษฐ์สร้างข้อมูลเท็จหรือชี้นำผิด

- ปัญญาประดิษฐ์ถูกมนุษย์ใช้เป็นเครื่องมือด้านมืด

- มนุษย์เชื่อใจปัญญาประดิษฐ์เกินไป มองว่าเป็นมนุษย์

- ผลกระทบด้านสิ่งแวดล้อมและเศรษฐกิจจากปัญญาประดิษฐ์ (ทำให้คนตกงาน หรือเหลือแต่งานที่แย่ลง)

ที่มา - DeepMind

Comments

"Gopher นั้นไม่สามารถแสดงความไม่แน่ใจเวลาที่หาคำตอบไม่ได้ แต่กลับให้คำตอบอย่างผิดๆ ออกมาแทน"

คนเราก็เป็นน่ากลัวเหมือนกันเวลาคุยกับคนแบบนี้

when you trust someone, but they just passed their opinion as a fact.

เท่าที่ผมดูในกราฟนี่ Gopher ก็ชนะ GPT-3 ทุกหมวดนะครับ แต่ไปแพ้ในหมวดวิทยาศาสตร์กับคณิตศาสตร์ให้กับ UnifiedQA ซึ่งเป็น AI จากสถาบัน Allen AI ของอดีตผู้ก่อตั้งบริษัท Microsoft "Paul Allen"

?

จริงๆคือตอบตามที่เข้าใจ แต่มองว่า มั่นใจเกินสินะ...

คือน่าจะเป็นประเภทที่ว่า ไม่รู้ว่าตัวเองไม่รู้สินะ อันนี้น่ากลัวจัด ๆ

สามารถอนุมานคำตอบจากความรู้ไม่ 100% ได้ นี่ใกล้เคียงมนุษย์มากเลยนะ

ผมรู้สึกว่าคนไทยเป็นแบบ Gopher เยอะเพราะโรงเรียนสอนว่าการไม่รู้เป็นเรื่องน่าอับอาย เคยจอดถามทาง ไม่รู้แทนที่จะบอกว่าไม่รู้ดันชี้มั่วไปคนละทางเสียเวลามาก

วิทยาลัยเคยสอนผมแบบนี้จริงๆครับ ยืนยัน แต่ผมไม่ทำตามนะ เวลาเด็กถามถ้าผมไม่รู้ก็ตอบไม่รู้ๆๆๆๆ

แล้วก็เดินหนีขึ้น s-classพื้นที่สีขาวกับสีดำน่ะไม่ยาก แต่พออยู่ในพื้นที่สีเทานี่สิยาก

ยากที่จะตัดสินว่าสิ่งนั้นจะอนุมานได้ไหมและถ้าตัดสินจะอนุมานมันออกมาการอนุมานจะถูกไหม

หรือจะตัดสินไปเลยว่าสิ่งนั้นอนุมานไม่ได้และบอกไปเลยว่าไม่รู้

แต่ถ้ายกให้ทุกอย่างเป็นสิ่งอนุมานไม่ได้ เพื่อจะไม่ให้ตอบอย่างผิดๆ แล้วเราจะสร้าง AI มาทำไม

นอกจากนี้ขอบเขตในการตัดสินสีเทายังแตกต่างกันไปตามหัวข้อ

บางเรื่องไม่มีพื้นที่ให้สีเทา อย่างเช่นเรื่งคณิตศาสตร์

แต่บางเรื่องพื้นที่สีเทาก็กว้าง อย่างเช่นเรื่องมนุษยศาสตร์และสังคม