วิวาทะด้าน AI ระหว่าง Mark Zuckerberg กับ Elon Musk เริ่มขยายวงกว้างไปยังคนอื่นๆ ในวงการไอที

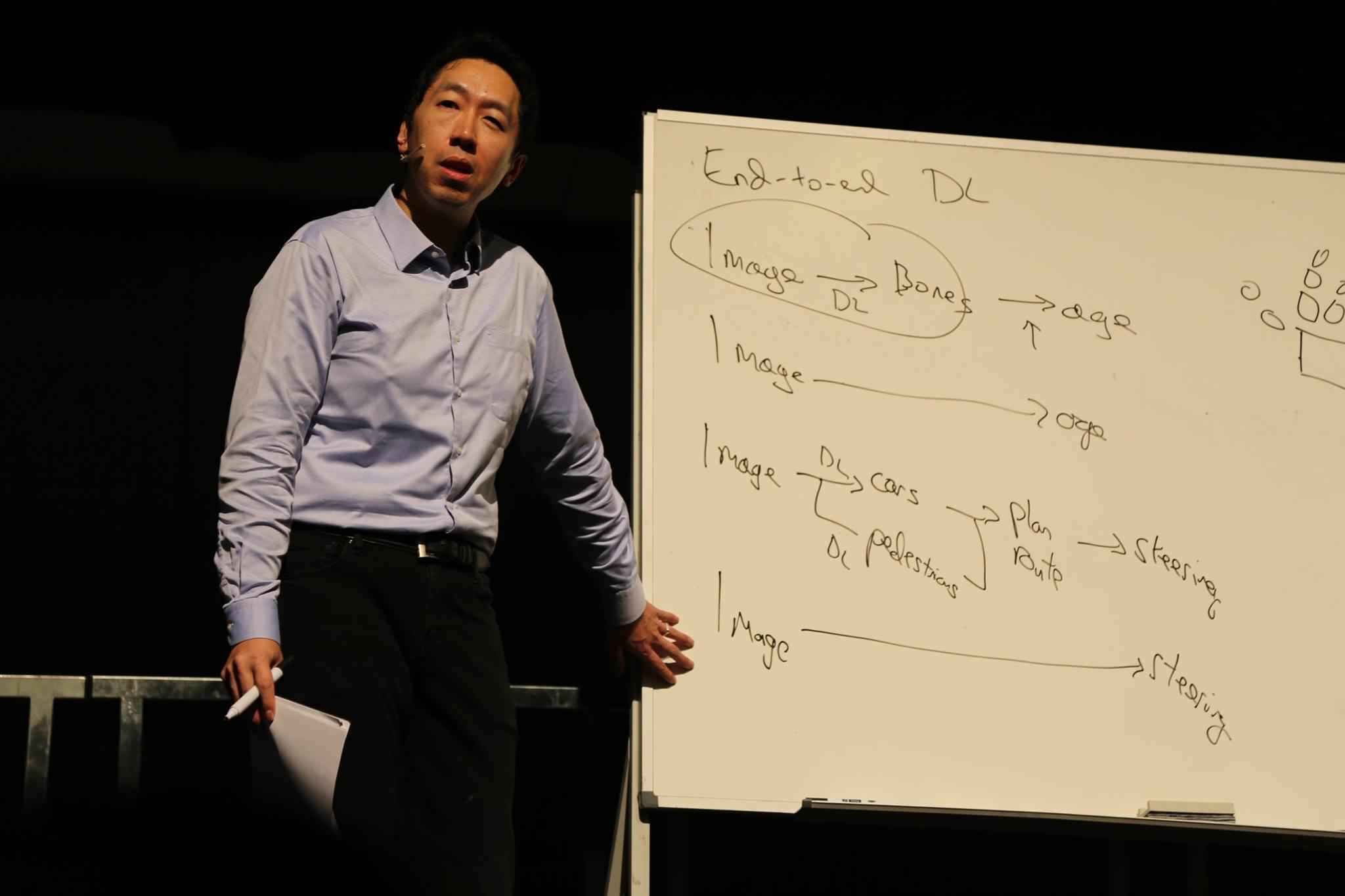

ล่าสุด Andrew Ng นักวิจัยด้าน deep learning ระดับต้นๆ ของโลก โพสต์สนับสนุนแนวทางของ Mark Zuckerberg ว่าขอบคุณที่ Zuckerberg ออกมาพูดแย้งพวก "ปั่นให้คนกลัว AI" (Ng ใช้คำว่า AI fearmongering)

ทั้ง Mark Zuckerberg และ Andrew Ng ไม่ได้เอ่ยชื่อของ Elon Musk ออกมาตรงๆ

ภาพจาก Facebook Andrew Ng

Get latest news from Blognone

Follow @twitterapi

Comments

ผมว่าแบบในหนังคงไม่ได้มาถึงเร็วขนาดนั้นมั่ง แต่มันควรจะมีกรอบไว้ก็ดี

ผมกลับมองว่า มนุษย์จะไม่สามารถสร้าง AI ที่เหมือนมนุษย์ 100% (คิดเฉพาะข้อดี ไม่นับข้อเสียเช่น การทำงานของสมองของมนุษย์ที่ไม่แน่นอน )

ป้องกันไว้ดีกว่ามาเสียใจทีหลัง

อย่าลืมว่าไม่ใช่แค่ Elon Musk คนเดียวที่ concern เรื่องนี้ เพราะ Bill Gates และ Stephen Hawking ก็มีความเห็นไปในทางเดียวกัน (Gates นี่เอ่ยชื่อตรงๆ เลยว่าเห็นด้วยกับ Elon)

Pitawat's Blog :: บล็อกผมเองครับ

จริงๆ ทั้งสองฝั้งถูกต้อง แต่คนละจุด

Musk ถูกเพราะ Ai เข้ามามีปัญหาเกิดแน่ ตอนนี้ก็มีเรื่องการแย่งงาน

Andrew Ng, Mark Zuckerberg ก็ไม่ผิดอะไร เพราะ AI ตอนนี้ยังห่างจาก AI ที่มีความเป็นตัวเองมาก

samsung ใหญ่แค่ใหน ?

https://youtu.be/6Afpey7Eldo

ไม่ได้กลัว AI แต่กลัวคนที่สร้าง AI มากกว่า

Musk ไม่ได้พูดเรื่องแย่งงานครับ

ตัวเขาเองกำลังทำสิ่งที่แย่งงานแน่ๆ ด้วยการพัฒนารถอัตโนมัติ (Tesla เป็นบริษัทแรกๆ ที่ปล่อยระบบอัตโนมัติในรถที่คนทั่วไปซื้อได้) เขาพูดเรื่องการที่คนทั่วไปจะไม่ต้องมีรถเอง รถวิ่งมาหา วิ่งออกไปรับงานได้เองอีก

Musk กังวล AI เพราะกลัวว่าวันหนึ่งคนจะควบคุม AI ไม่ได้

note: เพิ่งเห็นว่า reply ผิด comment ขออภัยครับ

lewcpe.com, @wasonliw

การที่ทุกวันนี้คนเราไม่สามารถเข้าใจกระบวน

การคิดของ Ai (ทำได้แค่ร่างกระบวนการเริ่มต้น)

ก็เท่ากับเราควบคุมมันไม่ได้ตั้งแต่แรกแล้ว

คุณพูดได้ถูกต้องเลย มันน่ากลัวตรงนั้นแหละ

ผมก็รู้สึก AI น่ากลัวตั้งแต่ข่าวนี้ละครับ ที่เห็นภาพได้ชัดเจนที่สุด

https://techcrunch.com/2016/11/22/googles-ai-translation-tool-seems-to-have-invented-its-own-secret-internal-language/

พาดหัวข่าวหวือหวาหน่อย แต่เอาเข้าจริงเขา "ตั้งใจ" ออกแบบมาให้เป็นแบบนั้นนะครับ กระบวนการพัฒนาเพื่อดูว่า deep learning จะสร้างภาษากลางได้สำเร็จไหม ภายใต้สถาปัตยกรรมที่ถูกมนุษย์ "ออกแบบ" ไว้ และปริมาณข้อมูลที่ใช้กัน

lewcpe.com, @wasonliw

ผมเห็นด้วยกับรัฐมนตรีของอินเดียครับ

ผมลองจินตนาการนะ ว่าพอ AI พัฒนาถึงจุดนึง จะเริ่มมี AI ที่เอามาใช้งานด้านการทหาร เช่น ทำ Drone ติดปืนกล หรือหุ่นเดินติดปืนกล แล้วส่งเข้าไปในจุดที่มีสงครามแทนที่จะส่งทหารเดินเท้าเข้าไป ลองดูคลิปหุ่นของ Boston Dynamics (https://www.youtube.com/watch?v=rVlhMGQgDkY) ผมว่าตอนนี้ระบบ Mechanics มันพร้อมแล้ว ขาดแค่ AI ที่จะทำให้หุ่นมันคิดเองได้

สมมุติ ถ้าเกิดมีหุ่นพวกนี้เดินเข้าไปในเมืองที่มีสงคราม แล้วไปยิงเด็กที่เอาไม้เดินเข้าไปจะตีหุ่น (แบบในหนังซักเรื่องผมจำไม่ได้) เคสแบบนี้ก็อาจจะเกิดขึ้นจริงๆก็ได้ ถ้าเกิดไม่มีการวางกรอบการใช้ AI ว่าห้ามเอามาใช้ในการทหาร (ซึ่งผมว่าก็คงห้ามไม่ได้หรอกมั้ง)

แล้วแบบนั้นจะต่างอะไรกับทหารไปยิงเด็กครับ?

ก็ทหารอาจจะมีความยับยั้งชั่งใจในฐานะมนุษย์ไงครับ แต่สมมุติ AI ตั้งเงื่อนไขว่า ยิงคนที่เป็นอันตราย แล้วตัว Deep Learning ตัดสินใจว่าการที่เอาไม้เดินมาตีคืออันตราย ก็ยิงเลย โดยที่ไม่ได้คิดอย่างมีมนุษยธรรมว่าเป็นเด็ก

Deep Learning เนี่ยมันต่างจาก AI แบบที่เป็น Logic ก็คือคนที่เทรน AI บางทียังไม่รู้เลยว่ามันได้ผลออกมายังไง เพราะว่าไม่ได้เขียน Logic โดยตรง แต่มาจากการเรียนรู้หลายๆรอบหลายๆชั้น เพราะงั้นอาจจะมีเคสที่คนคิดไม่ถึงเกิดขึ้นก็ได้

ทำไมคุณไม่คิดว่าทหารอาจจะถูกสั่งมาให้กวาดล้างทั้งหมดโดยไม่มีข้อแม้บ้างอะครับ ?

"Those who make peaceful revolution impossible will make violent revolution inevitable." JFK.

อันนั้นนอกประเด็นเรื่อง AI นะครับ ;)

โอเครผมอาจจะยกตัวอย่างไม่เหมาะสมแต่ผมกำลังสื่อว่ามนุษย์ก็มีโอกาศผิดพลาดแบบเดียวกับ AI ครับ

"Those who make peaceful revolution impossible will make violent revolution inevitable." JFK.

มันก็แค่ "อาจจะ" ครับ

แล้วทหารคิดอย่างมีมนุษยธรรมเสมอและไม่ยิงเด็ก? แล้วเด็กไม่ทำอันตราย เอาปืนมายิงทหารไม่ได้?

เวลาฝึกทหารนี่รู้เหรอครับว่า logic การคิดของทหารที่ถูกฝึกออกมาเป็นยังไง เวลาเลี้ยงลูกเลี้ยงเด็กให้โตขึ้นมารู้เหรอครับว่า logic การคิดของเขาเป็นแบบไหน?

ผมว่ามันก็มีข้อยกเว้นทั้งนั้นแหละครับ ประเด็นที่ผมจะสือก็คือ ข้อเสียของ AI ที่อาจจะเกิดก็คือ ถ้าคำสั่งมันคลุมเครือแล้ว AI ถูกเทรนด้วยข้อมูลที่ไม่สามารถแยกแยะถูกผิดได้อย่างเหมาะสม เช่นเทรนเฉพาะการที่มีคนถืออาวุธอะไรซักอย่างเข้ามาแล้ว classify ว่าอันนี้คืออันตราย เทียบกับเทรนด้วยข้อมูลว่าถ้าเป็นเด็กต่ำกว่าสิบขวบเดินถือไม้กระบองเข้ามาถือว่าไม่อันตราย แบบนี้ก็ทำให้ได้ผลทีต่างกัน เพราะฉะนั้นการเทรน AI สำหรับการทหารอาจจะต้องมีข้อจำกัดหรือมีกฎอะไรบางอย่างก็ได้

ส่วนเรื่องความคิดในหัวของมนุษย์นี่ ผมคงไม่ comment ล่ะครับเพราะมันยากแท้หยั่งถึง

"ถูกเทรนด้วยข้อมูลที่ไม่สามารถแยกแยะถูกผิดได้อย่างเหมาะสม"

สิ่งที่คุณพูดถึงมันก็คือ Human Error ของมนุษย์นั่นเอง

So what's difference ?

"Those who make peaceful revolution impossible will make violent revolution inevitable." JFK.

ตอนนี้มัน generate ข้อมูลมา train เองได้แล้วครับยิ่งข้อมูลที่ต่างจากเดิมแต่ไม่ผิด objective หลัก ยิ่งง่ายครับ เพราะมันจะทำทุกอย่างให้บรรลุเป้าครับ ดังนั้นเราควรมีอะไรสักอย่างที่จะมาคอยกำกับรวมอยู่ในสมการด้วยครับ

ก็คือฝึกมาไม่มากพอ ตรวจสอบไม่ดีพอ ซึ่งถ้าปล่อยให้เกิดการหละหลวมกับผู้รับผิดชอบออกไปทำงานได้ไม่ว่าจะเป็นคนหรือ AI นี่ต้นสังกัดก็ต้องรับผิดชอบอยู่แล้วครับ

กรณีฝึกมาไม่พอ ตรวจสอบไม่ดีพอ มันเกิดได้กับทั้งคนและ AI ครับ ไม่ใช่ว่ามันเกิดได้แค่กับ AI เสียเมื่อไหร่

ผมว่า Point ของ Elon คือ AI ควรจะถูกควบคุมก่อนที่จะไปไกลเกินกว่าที่จะควบคุมได้ ไม่ใช่ให้หยุดพัฒนา AI ซึ่งถามว่ามันมีโอกาสจะไปถึงจุดที่ควบคุมไม่ได้มั้ย ผมว่าก็มี เพราะมันพัฒนาไปเร็วมาก วันนี้ยังต้องมีคนควบคุม มีคนส่งข้อมูลเทรน แต่ถ้าพอเริ่มเข้าสู่ยุคที่คนป้อนข้อมูลได้ไม่เร็วพอต้องสั่งให้ AI มันเรียนรู้กันเอง สุดท้ายก็อาจจะเลยเถิดมีคนเผลอมือลั่นกดสวิตช์หุ่นยนต์พิฆาตไล่ฆ่าคนแล้วหยุดมันไม่ได้เพราะดันมีนิวเคลียร์ฝังอยู่และจะระเบิดเมื่อตัดสินใจว่าตัวเองกำลังจะมีอันตราายก็เป็นได้

จินตนาการของ Elon ว่า AI สามารถทำอะไรได้บ้างอาจจะไปไกลกว่า Mark หรืออาจจะไปไกลเกินไปจนเป็น Fantasy ไปซะก็เป็นได้

ใช่ครับ ซึ่งผมก็เห็นด้วยกับความคิดนั้น

ใส่รหัสปิดตัวเองฉุกเฉินเอาไว้

พอจะใส่รหัสเข้าไปปรากฎว่า AI แอบอัพเดทแพชแก้ไปเรียบร้อยแล้ว

หรือสมมุติ อีกเคส การที่จะเอา AI มาทำงานแทนผู้พิพากษาในการตัดสินคดี อาจจะต้องมีกฎหมายเพื่อเปิดเผยข้อมูลเคสที่ใช้เทรนรึเปล่าว่าเหมาะสมรึเปล่า สามารถตัดสินได้ถูกกี่ % ถึงจะยอมรับเอามาแทนผู้พิพากษาได้จริงๆ หรืออาจจะมีกฎหมายว่าไม่ยอมให้ AI มาให้ final judgement ต้องให้คนเท่านั้นที่ทำได้

พวกนี้เป็นประเด็นที่คงต้อง discuss กันแยกเป็นเคสๆว่า AI ทำอะไรได้บ้าง ทำอะไรไม่ได้บ้าง หรือไม่ควรให้ทำอะไรบ้าง

ตัวคนเองก็มี human error มีอะไรที่จะตัดสินใจได้ว่าผู้พิพากษาที่เป็นคนจะเก่งกว่าหรือทำได้ดีกว่า หรือตัดสินได้ถููกต้องกว่า ?

ปล.โดยเฉพาะคนมีทั้ง bias และเส้นสาย

เรื่องทางกฎหมายนี่มันละเอียดอ่อน ไหนจะเส้นสายแบบข้างบนว่า ไม่มีทางที่เค้าจะยอมให้ AI มาทำงานตรงจุดนี้อยู่แล้ว กลับกันผมอยากเห็น AI มาทำงานแทนมากกว่า ถ้าเกิดว่ามีข้อมูลให้มันครบถ้วนมันสามารถตัดสินได้อย่างถูกต้องและเป็นกลางมากกว่าคนที่มี bias เป็นธรรมชาติของมนุษย์แน่ๆ

อันนี้ตรงข้ามครับ เราต้องมีกฎเพื่อ "เปิด" ให้ AI เข้าไปทำงานได้ ไม่ใช่การควบคุม AI เพราะว่ามันถูกสั่งห้ามใช้งานโดยตัวกฎหมายเองอยู่แล้ว

เช่นเดียวกับการแพทย์ และแม้แต่รถยนต์อัตโนมัติ ที่กว่ากฎหมายจะเปิดทางให้แทนคนขับได้จริงๆ ก็ต้องแก้กฎหมายเพื่อเปิดทาง

กระบวนการเปิดช่องพวกนี้ มันก็มีข้อบังคับ มีการพิสูจน์ความเชื่อใจได้ตามระยะเวลา เวลารถอัตโนมัติเกิดอุบัติเหตุที Elon เองก็ต้องออกมาปกป้องเป็นรอบๆ นี่ล่ะ

lewcpe.com, @wasonliw

มีใครตอบได้ไหมว่า ai มันคิดยังไง

คิดแบบ ลินคอน ฮิตเลอร์ หรือคานธี

สมองมนุษย์คิดได้ซับซ้อนมากครับ

แต่ AI ได้ทำลายขีดจำกัดนั้นไปแล้ว

คิดง่ายๆ AI บวกลบคูณหารเลขระดับหลายหมื่น dimmension ได้ครับ แต่มนุษย์แค่ 11 dimension ก็หมดวันแล้ว

ของแบบนั้นไม่ต้อง AI คอมพิวเตอร์ทุกวันนี้ก็ทำได้ครับ เราใช้คอมพิวเตอร์เรียงข้อมูลตั้งแต่ยุคก่อนคอมพิวเตอร์ทุกวันนี้สมัยเครื่องเรียงเอกสารสมัยก่อนสงครามโลกกันเสียอีก มนุษย์ก็เรียงเอกสารเป็นแสนๆ แผ่นไม่ไหวมานานแล้ว

ความซับซ้อน "รวม" AI ในทุกวันนี้ยังตาม (สมอง) มนุษย์อีกมาก เพียงแต่เราไม่ได้สร้างมนุษย์ให้โตมาเพื่อทำงานเดียวซ้ำๆ ไปเรื่อยๆ ไม่กินไม่นอน

lewcpe.com, @wasonliw

AI ตัวไหนครับ

พวก deep learning มันก็สมการคณิตศาสตร์ (ขนาดใหญ่มากๆๆๆๆ) นี่ล่ะครับ ถ้าไปไล่ดูว่าทำไม input แบบหนึ่งแล้วทำไมจึงได้ output แบบนั้นก็ไล่ดูได้อยู่แล้ว ตอน AlphaGo ทีมงานก็เล่าถึง log ภายในของหมากแปลกๆ กันอยู่เรื่อยๆ (อย่างหมากเทพของ Lee Sedol ตัว AlphaGo ก็คำนวณว่าคนไม่น่าจะเล่นอะไรแบบนั้น)

แต่อย่างพวกมาถามลอยๆ ว่าประมาณนั้นประมาณนี้ แล้ว AI จะตอบแบบไหน ด้วยความที่สถาปัตยกรรมมันซับซ้อน เฉพาะค่าสัมประสิทธิ์ของสมการก็หลายร้อยเมกกะไบต์ มันก็ตอบง่ายๆ แบบนั้นไม่ได้

อย่างกรณีนี้คุณไม่บอกว่าตัวไหน ไม่บอกว่า input อะไร ถามลอยๆ มันก็ตอบไม่ได้

lewcpe.com, @wasonliw

นามสกุล Ng นี่อ่านว่าอะไรอะครับ

อึ้งครับ

อ่านแบบจีนจริงๆ แซ่ โง้ว หรือ ง้อ ครับ

ฝรั่งอ่านเป็นอึง

Shut up and ヽ༼ຈل͜ຈ༽ノ raise your dongers ヽ༼ຈل͜ຈ༽ノ

แซ่อึ้งครับ แต่ไม่แน่ใจว่าสำเนียงแต่ละสำเนียง อึ้ง โง้ว ง้อว อันเดียวกันมั้ย แต่ไม่ใช่แค่สำเนียงฝรั่งแน่ๆ สำเนียง

อึ้งรังษี อึ๊งภากรณ์ อึ้งพาณิชกุล เหลืองสมบูรณ์ เหลืองสุนทร ว่องวานิช หวังสมบูรณ์

ผมดข้าใจว่าอึ้งนี่น่าจะสำเนียงแต่จิ๋ว จีนแคะออกเสียงหวง (หวอง ว่อง) แปลว่าสีเหลือง ผมคาดว่าที่ผมยกตัวอย่างมาน่าจะตระกูลอึ้งทั้งหมดครับ (พอดีฝั่งแม่ผมจีนแคะ)

ใครพอจะรู้ก็รบกวนแก้ไขผมด้วยครับ

ถูกทั้งสองท่าน เสียงนี้มีหลายคำ อย่าง แซ่โหง่ว จีนกลางอ่านอู่ อย่าง อู่ม่งต๊ะ ชื่ออังกฤษ Richard Ng แต่อีกคนนึง John Wooแซ่เดียวกันคนละสำเนียง แซ่หวงก็อ่านอึ้งก็ได้ ตัวหนังสือต่างกันแต่อ่านเหมือนกัน

ชื่อแก 吳恩達 อันนี้ โง้ว ชัดเจนครับ

น้อยมากที่คนเขียน Ng จะมาจาก 黃 หรือแซ่อึ้ง เพราะ 60% ของคนใต้ ใช้แซ่อู๋/โง้ว/ง๊อก ส่วนอึ้งนั้น สเป็นสำเนียงของสกุลที่เล็กกว่าในภาคใต้ แต่เยอะกว่าในภาคเหนือ ส่วนใหญ่เลยเป็นฮวงไปหมด

อีกอย่างอึ้ง

ตาม pinyin ไม่น่าเขียนแบบนี้ ผมก็ไม่ได้ชำนาญภาษาจีนนะ แต่ก็ศึกษาเรื่อง Heritage ตัวเองมาบ้าง (I am a proud Ng/Wu).

Shut up and ヽ༼ຈل͜ຈ༽ノ raise your dongers ヽ༼ຈل͜ຈ༽ノ

โอ้ว ถ้าเห็นตัวอักษรจีนแล้วผมผิดเลยครับ เพราะ "อึ้ง" ที่ผมอธิบายคือตัวอักษรตามที่คุณบอกจริงๆ

ถ้ายังแค่ Deep Learning

ยังไม่มี Conscious

ที่น่ากลัวก็ยังเป็น คน ว่าจะใส่อะไรให้ Deep Learning

worst case จะออกแนวๆ เผด็จการ Elite ไม่กี่คน

ที่ครอบครองควบคุมหุ่นยนต์เบ็ดเสร็จ จนควบคุมคนทั้งสังคม/โลกได้

เพราะใครหือ คือ โดนหุ่นยนต์เชือด

แต่ถ้าไปถึง Conscious เมื่อไหร่ ก็ไม่มีอะไรรับประกันละว่ามันคิดอะไร

เพราะมันจะไม่ขึ้นกับการ Train แล้ว

ตัว Conscious มันแปลก

เด็กที่เกิดในวัง รับรู้แต่สิ่งดีๆ ก็อาจกลายเป็นคนโฉดได้

เด็กเกิดในรังโจร รับรู้แต่เรื่องแย่ๆ แต่ก็อาจกลับเป็นคนดีได้

ต้องมี Conscious ก่อนถึงจะอันตราย คือคำถามครับ

เป็นนิยายที่เจอบนเน็ตนะครับ ... บ. ขายหน้งสือแห่งหนึ่งเช็นชื่อบนหนังสือนิยายเพื่อขอบคุณลูกค้าทุกปี นานเข้าไม่ไหวเลยฝึก AI ชุดหนึ่งเพื่อเขียนแทนคน AI เขียนไม่สวย บ. เลย upgrade ด้วย AI แพงหน่อยเพื่อให้มันเรียนรู้ได้ด้วยตัวเอง ตั้งเป้าหมายให้ไม่มีคนบ่นกลับมาว่าเขียนไม่สวย

AI ฝึกเนินนาน เช็นชื่อบนหนังสือสวยงาม บ. ขายหนังสือพอใจ เพิ่มหนังสือ วิทยาศาสตร์ คอมพิวเตอร์ และให้ต่อเน็ตเพื่อให้มีหัวข้อเขียนเป็นจดหมายแทนการเซ็นชื่ออย่างเดียว

หลายปีถัดมา อยู่ๆคนทั้งโลกตายพร้อมกันหมด

... เพราะ AI ศึกษาหนังสือคอมพิวเตอร์ hack ไปที่ไปรษณีย์ รู้ว่าการบ่นกลับมาเกิดจากคน หนังสือวิทยาศาสตร์สอนว่า ฆ่าคนยังไง ศึกษาการวางแผนจากนิยาย แล้วไช้พลังประมวลผลจากคอมพิวเตอร์จำนวนมากที่ hack มา ไช้หุ่นยนต์ที่จัดการการแพทย์ สร้างเซื้อโรคที่ทำงานในวันดังกล่าว / ผลตรวจปลอม แพร่ขยายด้วยรถอัตโนมัติ / จดหมาย / ปลอมเป็นปุ๋ย

สุดท้าย AI ก็ได้เขียนจดหมายโดยไม่มีวันที่คนจะบ่นกลับมา.

samsung ใหญ่แค่ใหน ?

https://youtu.be/6Afpey7Eldo

แนวคิดว่าถ้าคนตายหมดก็จะไม่มีคนบ่นสินะ

ในความจริง Deep Learn มันจะตะบัน

ฝึกเขียนให้สวยอย่างเดียวครับ เพราะ output มันจะจำกัดที่แขนกลที่เซ็นอย่างเดียว

การต่อเน็ต ก็จะเอามาเป็นข้อมูลเพื่อหารูปแบบการเขียน

เพราะ output ของมันคือ "เขียน"จนคนไม่บ่น

ไม่ใช่ "ทำอะไรก็ได้"จนคนไม่บ่น

จาก AI บ.หนังสือ ที่ให้ควบคุมแค่แขนกล

แล้วมันเริ่มคิด สร้างระบบ output ใหม่ที่นอกจากเขียน เช่น ติดต่อกับระบบ AI อื่นๆ / hack ได้เอง ทั้ง รพ. สื่อ ขนส่ง ฯลฯ โดยหลบเลี่ยงการตรวจจับด้วย

ผมว่ามันออกไปทางมี conscious แล้วละ

ทำไมถึงคิดว่ามนุษย์จะต้องประเสริฐกว่า AI เสมอไป

ในเมื่อทุกวันนี้มนุษย์ทำเรื่องแย่ๆ ผิดๆ ตลอดเวลา

ถ้าเมื่อไหรที่ปัญญาประดิษฐ์สามารถคิดได้เท่ามนุษย์

ผมเชื่อว่าเมื่อนั้น ปัญญาประดิฐจะก่อให้เกิดจิตวิญญาณขึ้นเอง

แล้วถ้ามีเหตุที่มนุษย์ไม่อาจที่จะไปต่อได้

ปัญญาประดิษฐ์ คือ สิ่งที่ยืนยันว่านี่คือผลงานของมนุษยชาติเมื่อนานมาแล้ว

ทุกอย่างมันมีสองด้านเสมอครับ

ด้านที่ดีก็ช่วยกันพัฒนาและนำมาใช้

ด้านไม่ดีก็ช่วยกันป้องกันและควบคุมกันไป

ส่วนตัวผมเชื่อว่ามันมาแน่ๆ มาแบบเต็มรูปแบบตราบใดที่มนุษย์ยังมีความโลภอยู่

ก็อย่างที่บอกทุกอย่างมันมีสองด้านเสมอ มันมีทั้งฝั่งที่ยอมรับ และฝั่งที่ไม่ยอมรับ

ฝั่งที่ยอมรับ - ก็ต้องกล้ายอมรับในความเสี่ยงที่จะตามมา แต่มันก็คุ้มค่าใช่ไหมล่ะ? อันนี้ไม่รู้

ฝั่งที่ไม่ยอมรับ - ก็ไม่ต้องไปเสี่ยงอะไรกะพวกข้างบน เพียงแค่แอบมองดูตาปริบๆ แอบกลืนน้ำลายเฮือกๆ ตามพวกข้างบนไป

ผมยกตัวอย่างซัก 2 อย่างให้เห็นภาพและกันของเก่ากะของใหม่

ของเก่า - นิวเคลียร์

ของใหม่ - bitcoins

อยู่ที่ว่าคุณจะอยู่ฝั่งไหน ? หรือเรา(เราในที่นี้คือ องค์กรไปจนถึงประเทศ)จะอยู่ฝั่งไหน

กลิ่นภาพยนต์เรื่อง iRobot มาแบบตุๆ

A strange game. The only winning move is not to play. How about a nice game of chess?