NIST องค์การมาตรฐานอุตสาหกรรมสหรัฐฯ ออกเอกสารรวบรวมภัยจากการโจมตี machine learning และแนวทางเพื่อลดความเสี่ยงลง พร้อมกับเตือนว่าตอนนี้ยังไม่มีทางใดที่ป้องกันการโจมตีได้ทั้งหมด และนักพัฒนาควรระมัดระวัง

เอกสาร NIST AI 100-2e2023 ไม่ใช่มาตรฐานอุตสาหกรรมแต่เป็นการรวบรวมการโจมตีรูปแบบต่างๆ และแนวทางการลดความเสี่ยงเท่านั้น โดยเอกสารจัดรูปแบบการโจมตี 4 รูปแบบใหญ่ๆ ได้แก่

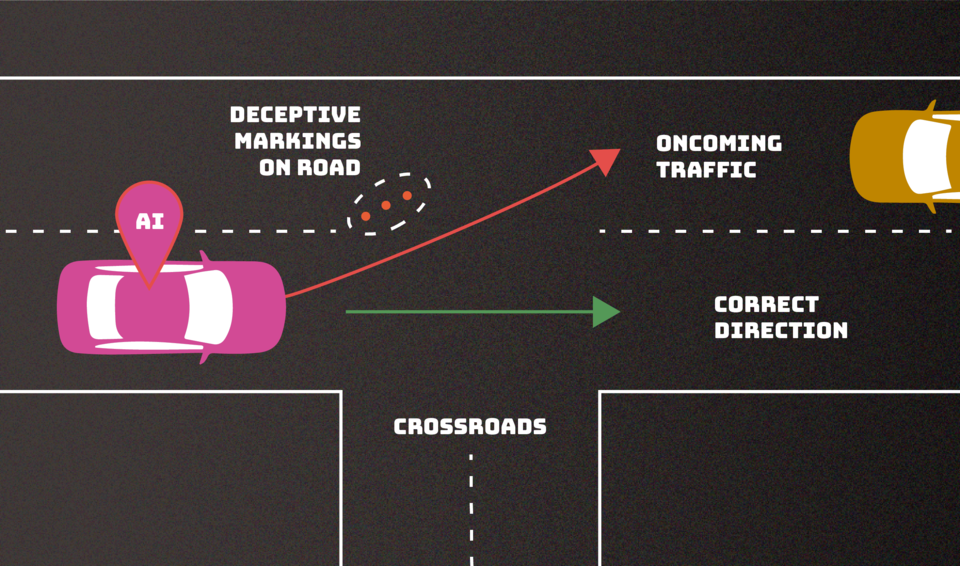

- Evasion attack: ผู้โจมตีพยายามใส่อินพุตเพื่อเปลี่ยนพฤติกรรมของ machine learning เช่นเหตุการณ์ผู้คนพยายามวางป้ายสัญญาณจราจรปลอมๆ เพื่อหลอกรถไร้คนขับ

- Poisoning attack: ใส่ข้อมูลมุ่งร้ายเข้าไปในชุดข้อมูลสำหรับฝึก machine learning เช่นการใส่ข้อความคำหยาบเข้าไปเพื่อให้ AI ตอบคำหยาบออกมา

- Privacy attack: พยายามล่อลวงให้ AI เปิดเผยข้อมูลส่วนบุคคลหรือข้อมูลความลับที่เกี่ยวกับตัว AI หรือเกี่ยวกับชุดข้อมูลที่ใช้ฝึก

- Abuse attack: ใส่ข้อมูลผิดๆ เพื่อให้ปัญญาประดิษฐ์ตอบผิด เช่น สร้างเว็บให้ข้อมูลหลอกเพื่อให้ AI ไปอ่านมาตอบ

เอกสารรวบรวมงานวิจัยที่มีการนำเสนอก่อนหน้านี้ ทั้งการโจมตีแบบย่อยๆ ภายใน 4 หมวดนี้ และเทคนิคการป้องกันการโจมตี อย่างไรก็ดีแนวทางการป้องกันที่มีการเสนอมาก็ยังป้องกันได้ไม่ครบถ้วน จึงนับว่าเป็นปัญหาที่ยังไม่สามารถหาทางออกได้ชัดเจนนัก

ที่มา - NIST

Get latest news from Blognone

Follow @twitterapi

Comments

โชคดีที่ pramool.com, ซังกะบ๊วยดอทคอม และ หลุดโลกบอร์ด เจ๊งหายไปซะก่อน ไม่งั้นมันต้องมีคนเอา data โยนลงไปแน่ ๆ .. เชื่อซิ อิอิ