NVIDIA เปิดตัวจีพียู Tesla รุ่นใหม่ในชื่อ V100 สำหรับงานดาต้าเซ็นเตอร์, AI แทน P100 เดิม ความน่าสนใจอยู่ที่ใช้จีพียูชื่อสถาปัตยกรรมใหม่ Volta ในรหัส GV100 ที่พร้อมผลิตเป็นการ์ดรุ่น GeForce ซีรีย์ 2000 ในลำดับต่อไป

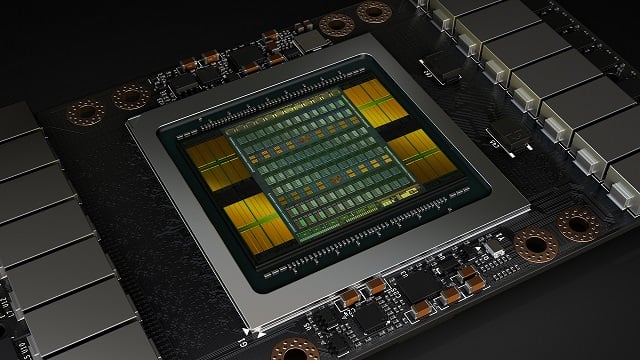

สเปคที่น่าสนใจของ Tesla V100 อยู่ที่จำนวนทรานซิสเตอร์ขึ้นไปอยู่ที่ 21 พันล้านหน่วย (จากเดิม 15.3 พันล้านบน P100) ผลิตโดย TSMC ที่เทคโนโลยีระดับ 12nm FF (จากเดิม 16nm FF) มากับ CUDA Core 5,120 หน่วย ถูกหารเป็น 84 Volta Streaming Multiprocessor ทำงานกับแรม HBM2 16GB แบนด์วิดธ์ 900GB/s รีดพลังประมวลผลได้ 15 FP32 TFLOPS ยังไม่มีสเปคความร้อนหรือสัญญาณนาฬิกาออกมา ในรูปแบบการ์ด PCI-Express และ NVLINK ครับ (สเปคทรงพลังเกินกว่าจะเล่นเกมจริงๆ)

ที่มา - NVIDIA

Get latest news from Blognone

Follow @twitterapi

Comments

อืม.. ใกล้ถึงเวลาเปิดตัว GTX Titan XP Service pack 1 แล้วสินะครับ

จาก p เป็น v แทน สงสัยจะเป็น Vista ครับ 5555

^

ใจเย็นๆ ครับ ผมเข้าความรู้สึกนะ

ปีที่แล้ว เดือน 6 เปิดตัว GTX Titan มา $1,200 (ซื้อนี่)

2 เดือนที่แล้ว เปิดตัว GTX 1080Ti มา $699 แต่แรงกว่า Titan (WTF ?)

พอโดนด่าเข้า เยอะๆ ก็ประชดออก GTX Titan รุ่นใหม่

เดือนที่แล้ว GTX Titan Xp แรงกว่า 1080Ti ประมาณ แมลงหวี่ กับ แมลงวัน บินแข่งกัน

(ซื้อตัวนี้ อีกรอบ ?)

เดือนนี้ ประกาศว่า Volta ที่จะมาเป็น Series 2000 ออกขาย ประมาณเดือน 7-8

ขอให้เจริญๆ นะครับ nVidia

15 'FP 32' TFLOPS -> 15 'FP32' TFLOPS จะดีกว่าครับ

ข้อสังเกตของ V100 คือ FP16 ไม่ได้เร็วเป็น 2 เท่าของ FP32 เหมือน P100 อีกแล้ว แต่เป็น 8 เท่าแทน!

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

เป็นหน่วยวัดใหม่ที่ผมเพิ่งเคยเห็นน่ะครับ เลยเว้นวรรคผิด ขอบพระคุณครับ

แสดงว่าใส่ ALU FP16 รัวๆ ไม่ได้เอา FP32 มาแบ่งครึ่งแล้ว?

lewcpe.com, @wasonliw

จากที่อ่านลิ้งที่คุณ k2w2yut โพสมาสรุปว่าเพิ่ม ALU แบบใหม่ขึ้นมาจริงๆครับ แต่ไม่ใช่ FP16 ปกติ โดยเป็น core เพื่อประมวลผล Matrix-Matrix multiplication (BLAS GEMM) -- Tensor Cores ซึ่งใช้ในงาน deep learning แทน FP32(@16) ALU แบบปกติครับ

ดังนั้นที่ผมเม้นไปว่า x8 อันนั้นคงผิดเพราะมันไม่ใช่ FP32/16 แบบปกติ(และน่าจะประมวลผล FP16 แบบปกติไม่ได้) ซึ่งคงต้องใช้การ optimize พอสมควร อันนี้ NVIDIA โฆษณาว่า

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

รายละเอียดเพิ่มเติมอ่านได้จาก blog CUDA แล้วครับ

”Each Tensor Core performs 64 floating point FMA mixed-precision operations per clock (FP16 input multiply with full precision product and FP32 accumulate, as Figure 8 shows) and 8 Tensor Cores in an SM perform a total of 1024 floating point operations per clock”

สรุปง่ายๆคือ"โกง"นับ FLOPS มันตรงๆเลย ไม่สนว่าเป็น 16/32/64

Peak FP32 TFLOP/s : 15 (32-bit each)

Peak Tensor Core TFLOP/s : 120 (1-bit each,1455x640x64x2)

*นอกเรื่อง เทียบกับ TPU ของ Google ที่ยัด 8-bit 256x256 MAC (10K fp/clock/unit) ดูยังห่างกันหลายขุม แต่ทางนั้นเน้น inference ล้วนๆไม่เน้น learning

ref:https://devblogs.nvidia.com/parallelforall/cuda-9-features-revealed/

ไอ้ FP32 นี่ไม่น่าจะถือว่าโกงหล่ะครับเพราะตัว shader มันให้ raw perf ได้แบบนั้นจริงๆไม่ต้อง optimize อะไร

แต่ตัว Tensor Cores นี่ถ้าไม่ได้ใช้ cuBLAS GEMM FP16->FP32 Mixed Precision นี่ก็แทบจะไม่ได้ประโยชน์อะไรเลย

Russia is just nazi who accuse the others for being nazi.

someone once said : ผมก็ด่าของผมอยู่นะ :)

ผมไม่แน่ใจถ้าไม่ได้ใช้ cuBLAS แล้วตัว compiler จะฉลาดพอ,หรือต้อง inline assembly เอาถึงจะใช้งานได้

งงครับ จากที่มา ตอนที่ "NVIDIA Tesla V100 Specifications" ยังระบุว่า

เหมือน Deep Learning ก็ยังไม่ใช่ Single-Precision

whitepaper ยังไม่ออกก็คงได้แค่เดาๆแหละครับ

2x FP32->FP16x2

2x FP64->FP16x4 native instruction ใหม่?

4x 8 TensorCore core ที่ใส่มาน้อยมากแต่ไม่บอกรายละเอียด?

ref:https://devblogs.nvidia.com/parallelforall/inside-volta/

ปล.Nvidia น่าจะหมดมุขไม่หั่นไม่แก้ SM ไปอีกพักใหญ่คงได้แต่ยัดตัวประมวลผลเฉพาะทางมากขึ้น - -

"สเปคทรงพลังเกินกว่าจะเล่นเกมจริงๆ"

ผมว่าไม่น่าจะจริงนะครับถ้าเอามาใช้กับ Dell UP3218K ที่ native นะครับ 555

ไม่น่าจะเล่นเกมได้รึเปล่าครับ เพราะ Tesla ไม่มี Output นิครับ

ก็เอาไปพ่วงกับ Quadro สิครับ ถ้ามันมีหัวต่อ SLI นะ 555+